Что влияет на индексацию сайта

Что такое индексация сайта

11 декабря 2017 Опубликовано в разделах: Азбука терминов. 31918

Индексация сайта значит, что робот поисковой системы посещает ресурс и его страницы, изучает контент и заносит его в базу данных.Впоследствии эта информация выдается по ключевым запросам. То есть, пользователи сети вводят в строку поиска запрос и получают на него ответ в виде списка проиндексированных страниц.

Если говорить простым языком, получится приблизительно так: весь интернет — это огромная библиотека. В любой уважающей себя библиотеке есть каталог, который облегчает поиск нужной информации. В середине 90-х годов прошлого века, вся индексация сводилась к такой каталогизации. Роботы находили на сайтах ключевые слова и формировали из них базу данных.

Сегодня боты собирают и анализируют информацию по нескольким параметрам (ошибки, уникальность, полезность, доступность и проч.) прежде, чем внести ее в индекс поисковой системы.

Алгоритмы работы поисковых роботов постоянно обновляются и становятся все сложнее. Базы данных содержат огромное количество информации, несмотря на это поиск нужных сведений не занимает много времени. Это и есть пример качественной индексации.

Если сайт не прошел индексацию, то информация до пользователей может и не дойти.

Как индексирует сайты Гугл и Яндекс

Яндекс и Гугл, пожалуй, самые популярные поисковики в России. Чтобы поисковые системы проиндексировали сайт, о нем нужно сообщить. Сделать это можно двумя способами:

Второй способ медленнее, сайт встает в очередь и индексируется в течение двух недель или больше.

В среднем, новые сайты и страницы проходят индексацию за 1–2 недели.

Считается, что Гугл индексирует сайты быстрее. Это происходит потому, что поисковая система Google индексирует все страницы — и полезные, и неполезные. Однако в ранжирование попадает только качественный контент.

Яндекс работает медленнее, но индексирует полезные материалы и сразу исключает из поиска все мусорные страницы.

Индексирование сайта происходит так:

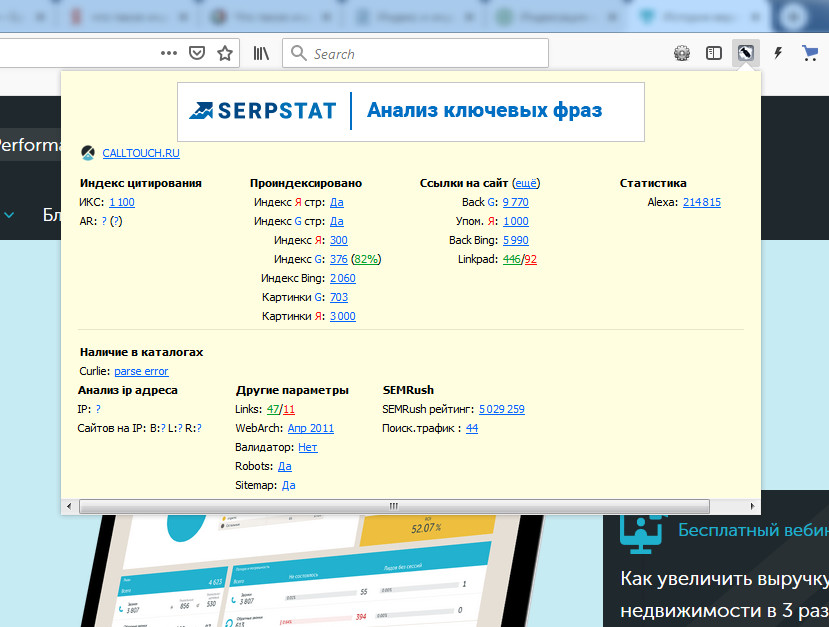

Есть 3 способа проверки индексации сайта и его страниц в Гугл и Яндексе:

Проверяем индексацию

Это можно сделать используя:

Как ускорить индексацию сайта

От того, насколько быстро роботы проведут индексирование, зависит скорость появления нового материала в поисковой выдаче, тем быстрее на сайт придет целевая аудитория.

Для ускорения индексации поисковыми системами нужно соблюсти несколько рекомендаций.

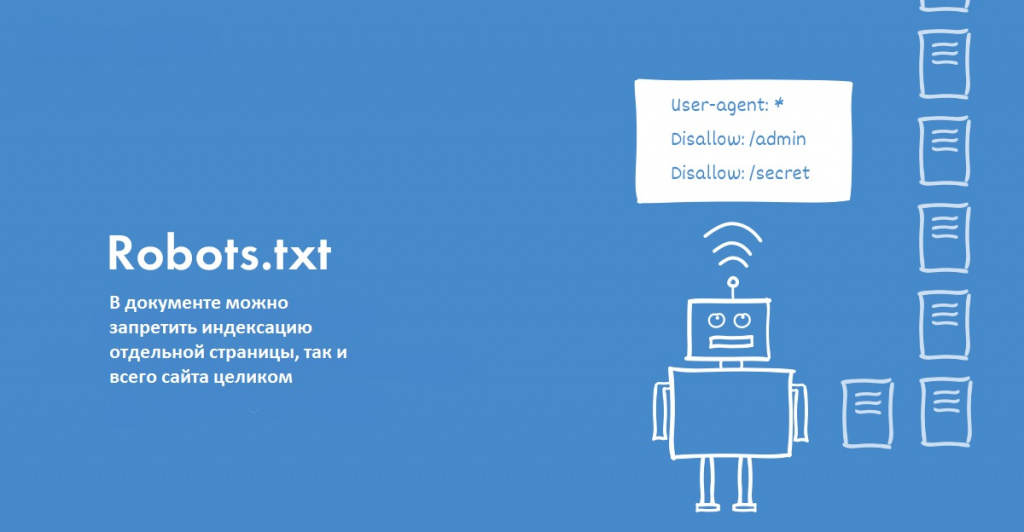

Как закрыть сайт от индексации

Закрыть сайт от индексации — запретить поисковым роботам доступ к сайту, к некоторым его страницам, части текста или изображению. Обычно это делается для того, чтобы скрыть от публичного доступа секретную информацию, технические страницы, сайты на уровне разработки, дублированные страницы и т. п.

Сделать это можно несколькими способами:

User-agent: *

Disallow: /

Запись для запрета индексации всего документа будет выглядеть так:

Можно создать запрет для конкретного робота:

На что влияет индексация при продвижении

Благодаря индексации сайты попадают в поисковую систему. Чем чаще обновляется контент, тем быстрее это происходит, так как боты чаще приходят на сайт. Это приводит к более высокой позиции при выдаче на запрос.

Индексация сайта в поисковых системах дает приток посетителей и способствует развитию проекта.

Кроме контента, роботы оценивают посещаемость и поведение посетителей. На основании этих факторов они делают выводы о полезности ресурса, чаще посещают сайт, что поднимает на более высокую позицию в поисковой выдаче. Следовательно, трафик снова увеличивается.

Индексация — это важный процесс для продвижения проектов. Чтобы индексирование прошло успешно, поисковые роботы должны убедиться в полезности информации.

Алгоритмы, по которым работают поисковые машины, постоянно меняются и усложняются. Цель индексации — внесение информации в базу данных поисковых систем.

Индексация сайта

Чтобы открыть онлайн-магазин, запустить информационный или развлекательный портал в сети необходим сайт – это, буквально, место или сегмент в виртуальном пространстве с уникальным адресом (домен), где размещается контент и файлы по проекту. Но чтобы ресурс можно было найти среди других, его необходимо «прописать» в специальной базе поисковых систем – индексе.

Что такое индексация сайта? Как её правильно выполнить и проверить? Можно ли ускорить этот процесс и полностью отказаться от него, на что влияет индекс? На все вопросы подробно отвечаем в этой статье.

Разбираемся в понятиях

Индексация страницы – это процесс сбора, проверки и внесения информации о контенте сайта в базу поисковых систем. Такая непростая и трудоемкая работа поручается специальным роботам, которые целиком обходят весь сайт и, следуя установленным алгоритмам ПС, собирают информацию со страниц. При индексации учитываются внешние и внутренние ссылки, графические элементы, текстовое наполнение и другое. Если ресурс проходит проверку, то он вносится в индекс ПС, то есть пользователи смогут его найти по поисковым запросам.

Вся информация в базе – это выжимка данных, собранных поисковыми роботами с сайтов в Интернете. Пользователю, обратившемуся к такой библиотеке через ПС, предлагается сначала каталог сайтов с релевантной запросу информацией. Поисковые системы ранжируют ресурсы по собственным алгоритмам, учитывая полезность, тематику и другие параметры. Ознакомившись с краткой информацией о ресурсе (заголовок + сниппет), пользователь кликает на позицию в выдаче и переходит на целевую страницу для дальнейшего изучения.

Попытки структурировать сайты в сети были приняты в конце 90-х годов прошлого века. В то время алгоритмы ПС только разрабатывались, поэтому индекс напоминал предметный указатель по ключевым словам, которые находили роботы на проверяемых страницах. Соответственно в ТОП выдачи часто проникали переоптимизированные и абсолютно бесполезные для пользователей сайты. За 20-30 лет развития алгоритмы отбора усложнились. Сегодня роботы смотрят не только на попадание контента в тематику, но и на его качество, полезность для людей, доступность сайта с разных устройств, скорость загрузки и многое другое.

Как индексируют Яндекс и Google

Для большинства пользователей Рунета, индексация в поисковых системах – это добавление сайта в базу Яндекса и/или Гугла. Обычно достаточно прописать ресурсы только в этих поисковиках, чтобы развивать свой проект. Провести индексацию, независимо от выбранной ПС, можно двумя способами:

Для сканирования сайтов существуют разные боты ПС. Например, проверку новых страниц перед внесением в индекс делает основной робот, который проверяет весь контент на ресурсе. Новую информацию на проиндексированных страницах проверяет быстрый робот в соответствии с графиком обновления. Также используются боты для сканирования новостной ленты, графического контента и другие.

Как проверить?

Алгоритмы индексации и соответственно скорость работы ботов Яндекса и Гугла отличаются. Считается, что Google проверяет страницы быстрее. Это связано с тем, что система сначала сканирует сайт полностью – полезные и неполезные страницы, но в выдачу пропускает только качественные ресурсы. Таким образом, попадание в индекс Гугла ещё не гарантирует место в выдаче.

Индексация сайта в Яндексе, что это такое и почему долго? Роботы ПС проверяют только полезные материалы, отсеивая мусорные страницы. Поэтому индексация затягивается. В любом случае сканирование контента на соответствие требованиям выполняют обе системы: Яндекс сразу, а Гугл после «прописки».

Проверить индексацию можно тремя способами:

Как ускорить?

От того, как быстро роботы ПС проверят новый контент напрямую зависит скорость появления страниц в поисковой выдаче. Соответственно на сайт быстрее придет аудитория и совершит целевые действия. Скорость индексации зависит от нескольких факторов:

Для ускорения индексации рекомендуется выполнить следующие действия:

Часто требуется уменьшить вес изображений, так как «тяжелая» графика замедляет загрузку страниц, плохо сказывается на индексировании и дальнейшем продвижении в поисковой выдаче.

Как закрыть страницы от роботов?

Выше мы узнали, что такое индексация страниц сайта, зачем она нужна, как ускорить этот процесс. Поговорим теперь, как спрятать от проверки информацию на страницах и зачем это делать. Обычно запрет на сканирование ботами ПС устанавливают, чтобы скрыть от публичного просмотра технические и служебные страницы, конфиденциальную информацию, ресурсы в разработке, дубли и другое.

То есть, чтобы качественно продвигаться в поиске, нужно знать, какие данные показывать, а какие скрывать.

Поставить запрет на сканирование ботами можно несколькими способами:

На что влияет индексация?

Благодаря «прописке» в поисковых системах Яндекса и Гугла, сайты попадают в поле видимости пользователей и потенциальных клиентов. Сама по себе целевая страница в сети, онлайн-магазин или Landing Page не представляет ценности. Полезность её определяют посетители. Соответственно находясь в индексе и регулярно обновляя контент, ресурс растет в выдаче. Это увеличивает приток трафика и помогает развивать проект.

Роботы ПС оценивают не только качество контента, но и поведенческие факторы, посещаемость, вовлеченность. С помощью этих метрик определяется полезность сайта. Чем лучше поведенческие факторы аудитории, тем выше страницы в ранге.

Первые 20 строк поисковой выдаче собирают 95% всего трафика по запросу. Поэтому быть в индексе на хорошем счету у ПС – это гарантия успешного продвижения и высоких конверсий.

Резюме

Мы рассмотрели, что такое индексация сайта в поисковых системах Яндекс и Гугла. Изучили основные моменты добавления, проверки и ускорения «прописки» в ПС. Узнали, как и зачем выставлять запреты на сканирование страниц ботами. У индексации простая задача, но с далеко идущими последствиями – внести информацию о сайте в базу поисковых систем.

Индексация сайта: принципы работы, советы, секреты

Сегодня рассмотрим подробно самый важный процесс, без которого остальные процессы SEO-продвижения не работают. Мы поговорим об индексации, принципах её работы, важности, отличиях в Google и Яндекс. Также расскажем, как проиндексировать сайт любого размера и улучшить его качество.

Индексация сайта и почему она так важна

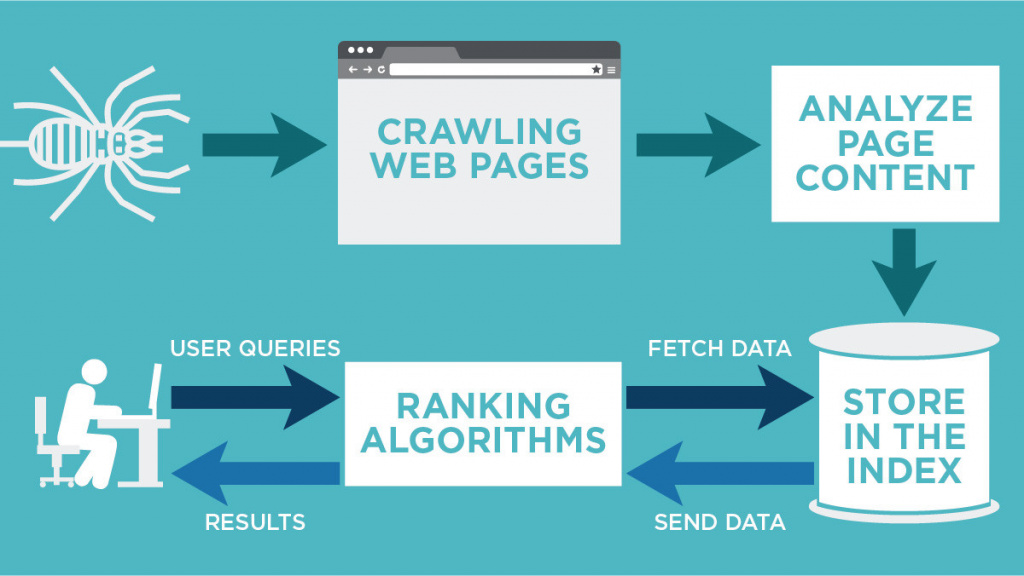

Как работает поисковая система?

Чтобы понять, что такое индексация, нужно сначала разобраться, как работают поисковые системы и почему их можно считать библиотеками Интернета.

Поисковая система — это множество серверов, на которых хранятся структурированные данные о миллионах, а возможно и миллиардах документов в Интернете. То есть когда мы запрашиваем какую-либо информацию в Google или Яндексе, мы ищем не по самому интернету, а по их поисковой базе.

Чтобы документ попал в эту базу, он должен быть известен поисковому роботу (краулер — от англ. crawler, бот, паук). Робот узнаёт о новых сайтах и страницах следующими способами:

Когда поисковой робот узнал о новом документе, он заносит его в расписание проверок и затем, если документ доступен для обхода, робот выкачивает преимущественно текстовую информацию (этот процесс ещё называют краулингом) и передаёт индексирующему роботу. После этого документ, сайт или страница могут участвовать в поиске.

Почему мы говорим о документе? Потому что робот умеет индексировать не только HTML-страницы, но и другие форматы (справка Яндекса и Google).

Что такое индексация?

Попробуем дать собственное определение этому понятию. Индексация сайта — это процесс получения, обработки, структуризации и хранения преимущественно текстовой информации о страницах сайта в поисковой базе. О получении этой информации мы уже рассказали. Под обработкой подразумеваем, что информация каждой страницы собрана и очищена от лишнего (картинки и графика, HTML-теги и т.д.). Но важнее всего остановиться на структуризации данных.

Вся полученная текстовая информация делится на отдельные слова, которые группируются в алфавитном порядке. Эти слова приводятся к их начальной форме. Алгоритмы каждой поисковой системы разнятся, поэтому мы не можем точно знать обо всех тонкостях процесса, но сам процесс называется машинной морфологией. К начальным формам слов робот добавляет адрес страницы и количество упоминаний на ней.

Почему так важна индексация?

Ответ прост: чем больше ваших страниц в поисковой базе (проиндексированы), тем больше возможностей для показа в поисковой выдаче. Выражаясь ещё проще, если вы в базе, вас могут найти.

Конечно, всё, что мы здесь описали, значительно упрощено для понимания, а некоторые тонкости и нюансы опущены. Например, логичен вопрос: вы говорите о возможностях, но не говорите о гарантиях показа. Дело в том, что индексация не гарантирует показ страниц вашего сайта, ведь после неё каждый раз включается процесс ранжирования документов по каждому отдельному запросу.

Ранжирование — это распределение страниц, имеющихся в поисковой базе, в порядке приоритета и релевантности для запросов пользователей. Если проще, то документы ваших конкурентов могут быть качественнее и релевантнее (более подходящими) по мнению поисковой системы, чем ваши. Поэтому даже если страницы вашего сайта будут находиться в индексе, не факт, что они будут показываться в поиске. А если и будут, то нет гарантий, что на 1–2 странице.

Тезис: чем больше страниц сайта проиндексированы, тем больше шансов получить трафик.

Что может мешать индексации?

Самая главная причина — робот не знает о наличии страницы либо сайта. Как мы обозначили выше, у краулера ограничены способы нахождения новых страниц. Учитывайте это и используйте все доступные меры:

Помешать индексации могут следующие причины:

Нюанс №1: для Яндекс robots.txt — важный документ, а для Google рекомендательный. То есть, если робот сочтёт страницу полезной для пользователей, он будет игнорировать запреты в файле. Для запрета индексации страницы в Гугле лучше использовать метатег robots или HTTP-заголовок X-Robots-Tag.

Нюанс №2: 3xx-редирект и атрибут rel=canonical не запрещают индексацию страницы напрямую, но указывают, что она вторична, в отличие от страницы редиректа или канонической.

Нюанс №3: указание канонической страницы не всегда спасает владельца сайта, так как Google может по своему усмотрению выбирать канонические страницы и игнорировать атрибут rel=canonical.

Краулинговый бюджет

Количество новых документов в Интернете постоянно растёт, а технологические мощности поисковых гигантов всё же ограничены. Поэтому робот решает, сколько страниц одного сайта будет индексировать за раз. Это и называют краулинговым бюджетом.

Он зависит от количества и качества страниц, частоты их обновления, типа самого сайта (маркетплейс, новостник, небольшой сайт), популярности и авторитетности ресурса. Важно отметить, что краулинговый бюджет — это не постоянная величина, и он может изменяться.

Напрямую управлять как индексированием, так и бюджетом сканирования вы не можете, но способствовать этим процессам точно можно. Об этом подробнее поговорим в разделе «Как управлять индексацией».

Индексация сайта в Google и Яндекс

Принципы индексации у этих поисковых систем преимущественно одинаковые: краулинг → очистка → индексация → ранжирование. Но различия можно найти, поэтому расскажем о тех, которые известны.

Индексация в Google

Самое главное отличие — Google лучше ориентируется в англоязычном сегменте, то есть лучше воспринимает текст и запрос пользователя на английском. Разница на момент 2020, думается, незначительная, но учитывать стоит.

У Гугла 2 основных типа роботов: для мобильных сайтов и для десктопных. Новые сайты индексируются мобильными роботами и приоритет отдан мобильным версиям сайта, согласно алгоритму mobile-first индекс.

Скорость индексации обычно выше, чем у Яндекса: на 1 страницу уходит неделя или меньше. Индекс обновляется постоянно, а некачественные страницы не удаляются из него, но при этом и не показываются пользователям.

Индексация в Яндексе

У Яндекса тоже 2 типа роботов: основной и быстрый (Orange). Основной робот занимается индексацией всего интернета, а быстрый отвечает за поиск самых свежих документов, чтобы информация была доступна как можно быстрее (от нескольких минут до пары секунд).

Обновление индекса происходит раз в несколько дней ночью, когда нагрузки на серверы меньше. Процесс индексирования сайта обычно занимает от недели до месяца, а некачественные страницы удаляются из индекса.

Как проверить индексацию?

Уточним сразу пару моментов. Индексацию нужно проверять как в Google, так и в Яндексе. Более того, вы должны знать изначальное количество страниц на сайте. Это можно сделать с помощью краулеров типа Xenu, Screaming Frog, Netpeak Spider и других.

Как проверить индексацию:

Индексация сайта в поиске

Теперь, когда мы рассказали, что такое индексация, почему она так важна и как её проверить, приступим к практике.

Как ускорить индексацию?

Мы писали выше, что управлять индексацией, что бы кто не говорил, вы не можете. Но повлиять на процесс или даже ускорить возможно.

Советы по ускорению индексации

Как запретить индексацию?

Выше мы рассмотрели основные способы, как ускорить индексацию, и рассказали, что такое краулинговый бюджет и почему он ограничен для каждого сайта. Поэтому чтобы его не тратить зря, советуем закрывать от индексации служебные и технические страницы, кабинеты пользователей и конфиденциальную информацию, а также страницы в разработке и дубли.

3 основных способа запретить индексацию:

Индексация многостраничных сайтов

Отдельным столпом стоит работа с краулинговым бюджетом для многостраничных сайтов: маркетплейсы, агрегаторы, интернет-магазины, новостники, форумы и другие. Скажем по секрету, что владельцам небольших сайтов (до 1000 страниц) о бюджете краулинга можно волноваться меньше. А вот владельцам многостраничников придётся нелегко.

Как улучшить индексацию многостраничного сайта:

Эта статья уже проиндексирована

Надеемся, что материал получился максимально полезным и интересным, а мы ответили на все вопросы, касающиеся индексации. Тема сложная, и сразу во всём не разобраться, но уверяем, что, если последуете нашим советам, вы только улучшите свой сайт и его качество.

Если всё-таки вопросы остались, задавайте их нам!

Что влияет на частоту индексации и как заставить поискового робота посещать ваш сайт чаще

От чего зависит скорость индексации сайта, как на нее можно повлиять и как сообщить роботу Яндекса и Google об изменениях на сайте. Читайте о том, как заставить роботов поисковых систем чаще заходить на ваш сайт.

Вебмастера часто сталкиваются с проблемой, когда страницы неделями не попадают в индекс поисковой системы. Особенно актуальна она в Яндексе – новые страницы в нем появляются значительно позже, чем в Google. А в последнее время Яндекс еще и редко делает текстовые апдейты – 2-3 раза в месяц. В этой статье мы рассмотрим, что влияет на индексацию сайта, как ее можно ускорить и как следить за ней.

Быстрые ссылки:

Что влияет на частоту индексирования сайта поисковым роботом

— Загруженность сервера, на котором находится сайт (качество хостинга)

Если на сервере находится много других ресурсов, а технические характеристики сервера не позволяют оперативно справляться со всеми запросами робота, робот начинает посещать такой сайт реже. Соответственно, ему потребуется больше времени для включения страниц в результаты поиска.

— Частота обновления сайта в целом

Поисковые роботы анализируют частоту обновления контента на сайте, в результате чего определяют, как часто будут посещать тот или иной сайт.

Чем чаще на сайт добавляется новый контент, тем чаще роботы ПС посещают его.

— Интерес посетителей к сайту (ПФ)

Поисковый робот может пересмотреть политику планирования и посещать сайт чаще, если на сайт регулярно добавляются новые материалы, интересные пользователям (например, новости, статьи):

Как улучшить индексацию сайта

Поисковый робот за один визит индексирует определенное количество страниц согласно выделенной квоте, которая зависит от множества параметров сайта. Т.е. даже если робот посетил ваш сайт, это еще не значит, что он проиндексирует и включит в свою базу все страницы сайта. Поэтому очень важно, чтобы робот-индексатор не только посетил ваш сайт, но и включил в свою базу все новые и измененные страницы сайта.

Ниже в статье мы рассмотрим, как заставить робота ПС чаще посещать ваш сайт и при этом увеличить количество страниц, которое за раз может проиндексировать робот ПС, – краулинговый бюджет.

1. Проанализируйте сайт на наличие дублей

Данный пункт поставили первым, так как дубли страниц – одна из основных проблем, которая ухудшает индексацию сайта поисковыми роботами.

Когда на сайте есть дубли, краулинговый бюджет тратится на бесполезные страницы вместо новых страниц или страниц с обновленным материалом.

О том, как найти на сайте дубли, подробно написано в статьях нашего блога:

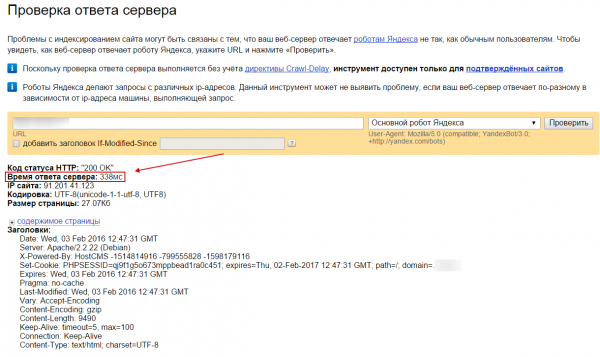

2. Настройте сервер на выдачу правильного HTTP-статуса

Корректная настройка кодов статуса HTTP очень важна для правильной индексации сайта.

Когда робот ПС запрашивает страницу сайта, код статуса предоставляет ему информацию о сайте и конкретной странице:

Например, код http «404 Not Found» сообщает, что страница по запрашиваемому адресу не существует, а код http «OK 200» сообщает, что страница доступна.

Также рекомендуем настроить заголовок Last-Modified.

Заголовок Last-Modified информирует робота ПС о дате последнего изменения документа. Таким образом, робот-индексатор проверяет на обновление только документы, действительно изменившиеся со времени предыдущего обхода, или новые страницы, не тратя при этом краулинговый бюджет на страницы, которые не менялись.

Подробно о заголовке Last-Modified здесь.

3. Мониторьте время отклика сервера и скорость загрузки страниц

Время ответа сервера на запрос браузера напрямую влияет на индексацию сайта.

С учетом сетевых задержек оно должно быть не более 300 мс.

Сервисы по измерению отклика сервера:

Для индексации сайта также очень важна скорость загрузки сайта.

Время загрузки страницы не должно превышать 3-5 секунд.

Сервисы по проверке скорости загрузки:

Увидеть, есть ли недочеты, можно с помощью сервиса Google PageSpeed.

4. Грамотно организуйте структуру сайта

Чем понятней для поискового робота выглядит структура сайта, тем он лучше будет его индексировать.

Рекомендации по структуре сайта:

— Уровень вложенности страниц

Любая продвигаемая страница должна быть не дальше, чем в 3 кликах от главной. Это очень важно для индексации, так как поисковому роботу потребуется гораздо меньше времени на индексацию простого и неглубокого сайта, чем на сложный ресурс с запутанной системой навигации.

— Реализуйте на сайте хабовые страницы

Хабовые страницы – это страницы, которые содержат ссылки на разделы и подразделы, служащие для навигации пользователей по сайту.

Для того чтобы улучшить индексацию, хабовые страницы необходимо реализовать в один клик от главной страницы сайта.

Что нам даст реализация хабовых страниц:

А. Уменьшит уровень вложенности

Б. Ускорит индексацию страниц поисковым ботом

В. Поможет пользователям легче найти нужный материал

Пример хабовой страницы:

— Выводите анонсы на новые страницы на главную сайта

Поисковый робот чаще всего посещает главную страницу сайта. Если на ней будут размещены ссылки на новые страницы или страницы с обновленным контентом, есть большая вероятность, что робот их проиндексирует.

— Реализуйте виджет в сайдбаре последних статей

Еще один хороший способ связать между собой страницы сайта:

— Не делайте меню на скриптах и flash

Главным недостатком использования меню на скриптах и flash является то, что поисковые роботы его не видят.

5. Настройте файл robots.txt

Корректно составленный robots.txt позволит исключить возможные проблемы, возникающие при сканировании сайта роботом. Это может значительно ускорить индексацию ресурса в целом.

В файле robots.txt нужно прописать инструкции для роботов поисковых систем: какие страницы сайта индексировать, а какие – нет. В таком случае поисковикам потребуется меньше времени для сканирования сайта.

Например, в robots.txt можно закрыть:

Как создать правильный robots.txt?

1. Создайте файл robots.txt в текстовом редакторе.

2. Заполните его в соответствии с правилами. Синтаксис Robots можно посмотреть в рекомендациях Яндекса для вебмастеров.

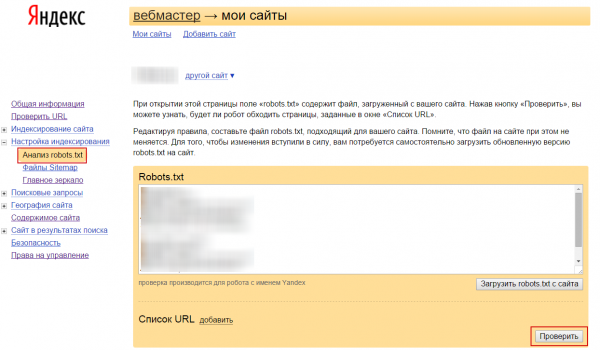

3. Проверьте файл в сервисе Яндекс.Вебмастер — > Анализ robots.txt.

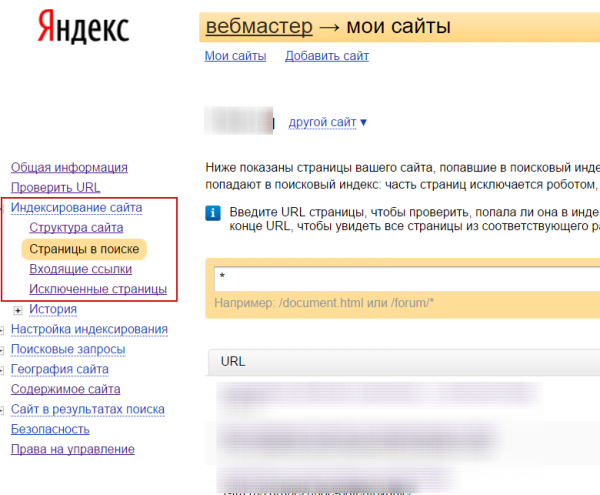

Скриншот из Яндекс.Вебмастера:

4. Если проверка прошла успешно и ошибок не обнаружено, загрузите файл в корень сайта.

6. Внешние сигналы ссылками

Чтобы ускорить индексацию сайта, рекомендуем привлекать на него роботов ПС с помощью внешних ссылок. Например:

7. Пишите качественный и уникальный контент

Качество контента также влияет на скорость индексации сайта. Плохой контент, который не дает полный ответ на запрос пользователя, в котором есть грамматические ошибки, большая плотность ключевых слов, индексируется хуже.

При написании текста важно учитывать, что:

Как следить за индексацией сайта

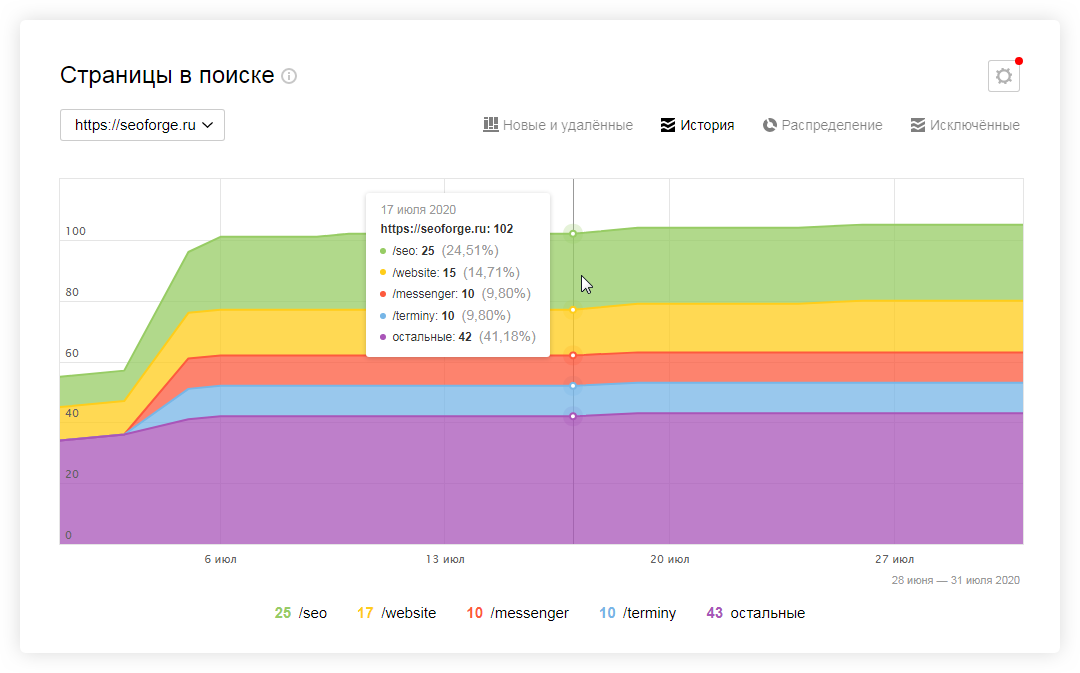

Добавьте сайт в сервис Яндекс.Вебмастер и Google Search Console

Если сайт еще не добавлен в панели вебмастеров поисковых систем, настоятельно рекомендуем добавить. С их помощью вы сможете легко анализировать индексацию проекта. Например:

Также вы можете сообщить ПС о новых или удаленных страницах и мониторить другие параметры сайта, не связанные с индексацией. Например, внешние ссылки, ведущие на сайт, запросы, по которым пользователи переходят на сайт, и т.д.

Только полный анализ сможет помочь вовремя выявить и исправить ошибки индексации сайта.

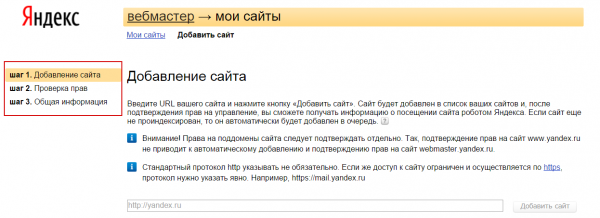

Зарегистрировать сайт в вебмастере Яндекса и Google просто.

Для этого нужно выполнить процедуру в 3 шага, которые сопровождаются подробной инструкцией, в Я.Вебмастер:

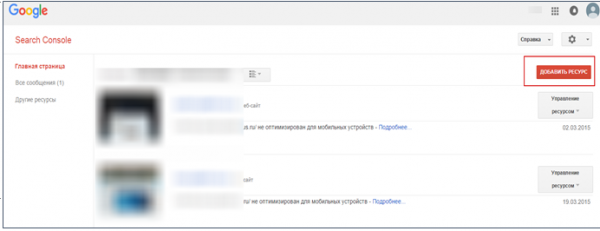

Добавление сайта в Google Search Console также сопровождается инструкцией:

Как сообщить роботу ПС об изменениях на сайте

— Создайте карту сайта

Чтобы помочь поисковому роботу найти новые страницы на сайте, рекомендуем создать карту сайта в двух форматах: xml и html.

Карту в формате html нужно выложить на сайт в качестве отдельной страницы. При сканировании сайта робот попадает на данную страницу – она должна содержать ссылки на все страницы сайта, а это поможет ему найти их.

Карту в формате XML (Sitemaps) нужо добавить в панель инструментов для вебмастеров Google и Яндекса.

Рекомендации по созданию карты сайта XML (Sitemap):

— Карта сайта должна автоматически генерироваться и обновляться при добавлении на сайт новых URL или удалении старых.

— В карту сайта не должны попадать закрытые от индексации страницы.

— После создания файла необходимо убедиться, что в нем нет ошибок. Сделать это можно при помощи специальных инструментов поисковых систем:

Также в карте XML (Sitemap) можно указать:

После того как карта сайта будет создана, информацию о ней нужно добавить в панель инструментов для вебмастеров Google и Яндекса.

— Напишите скрипт «Ловец ботов»

Для крупного проекта можно применить следующую методику – в момент прихода робота ПС на сайт специальный скрипт показывает роботу ссылки на не проиндексированные страницы сайта.

Недостаток использования методики – сложная техническая реализация.

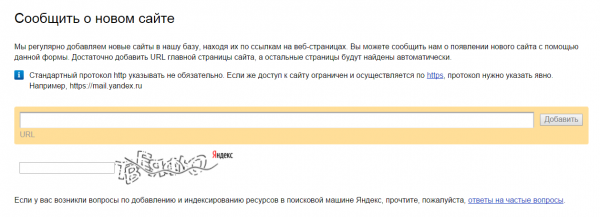

— Используйте « Add URL » поисковых систем

Это наиболее «традиционный» способ ускорения индексации новых страниц на сайте. С помощью « Add URL » поисковой системе можно сообщить как о новом сайте, так и о новой странице на сайте.

Ниже приведем ссылки на « Add URL » наиболее популярных поисковых систем:

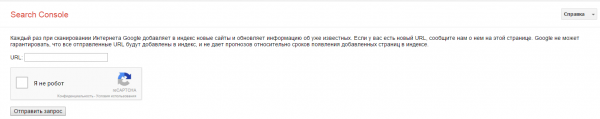

Чтобы сообщить о новой странице ПС Яндекс, используйте форму add url Яндекс:

Чтобы сообщить о новой ПС Google, используйте форму add url Google:

Недостаток использования этого инструмента – добавление страниц в данные формы не дает гарантий, что страница сразу же окажется в базе поисковой системы.

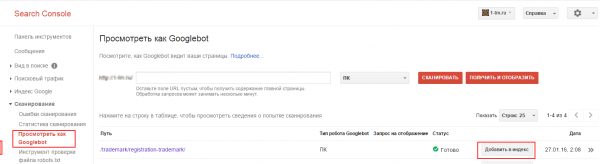

— Для быстрой индексации новых страниц в Google используйте инструмент «Посмотреть как Googlebot»

Воспользоваться данным инструментом можно после того, как сайт будет добавлен в Google Search Console (вебмастер).

Google Search Console — > Раздел Сканирование — > Посмотреть как Googlebot — > Вводим нужный URL — > Кнопка «Сканировать» — > Кнопка «Добавить в индекс», после чего появится надпись «URL отправлен на индексирование»:

Также с помощью данного инструмента можно узнать время загрузки страницы и данные по процессу сканирования.

Единственный недостаток – необходимо каждый раз при добавлении нового материала адрес вводить вручную.

— Плагин-пингер для ускорения индексации новых страниц в Яндекс

Повысить приоритет индексирования новых страниц сайта можно с помощью специальных POST-запросов. Подробнее здесь.

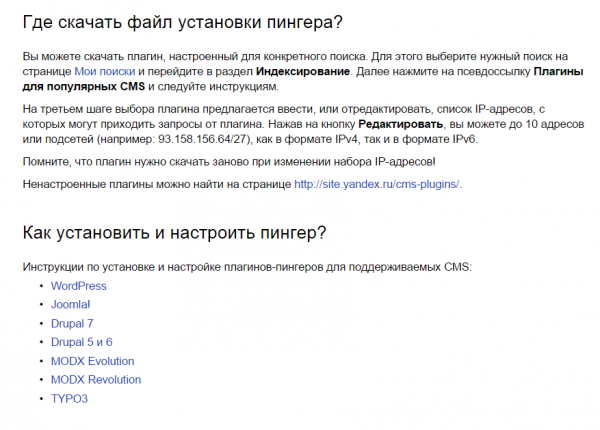

Если ваш сайт построен на основе популярных CMS, например, WordPress, Joomla, Drupal – установите специальный плагин Пингер. Он автоматически будет сообщать Яндексу о появлении новых страниц на вашем сайте.

Что для этого необходимо сделать:

Б. Установите и настройте плагин в соответствии с инструкцией:

После публикации новой страницы зайдите в настройки плагина, в окне «Сообщение о статусе плагина» должно появляться сообщение «Плагин работает корректно» и выводиться последний добавленный адрес.

Другие возможные статусы и их значения можно посмотреть здесь.

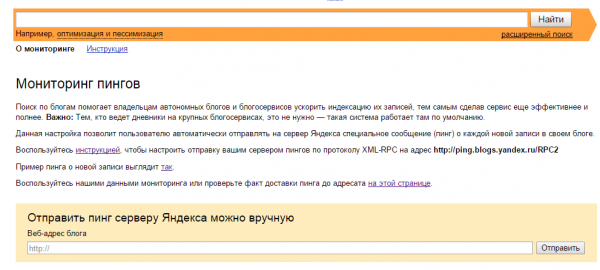

— Специальные формы ПС для ускорения индексации блога «Пинг»

Если у вас блог с подпиской на RSS, для ускорения индексации новых страниц вы можете использовать специальную форму ПС «Пинг».

«Пинг» – это оповещение поисковых систем об изменениях на вашем сайте.

Для добавления новой записи в ПС Google нужно использовать форму « Blog Search » по адресу:

Для добавления новой записи в ПС Яндекс нужно использовать форму « Отправить пинг » по адресу:

Для ускорения индексации новых документов используйте бесплатные сервисы пингования, например, https://seo-ng.net/seo-instrumenty/ping_services.html:

Важно! Сервисы пингования используйте только при наличии свежего материала на сайте. Также не стоит один и тот же сайт пинговать в разных сервисах.

Подведем итоги – чтобы ускорить индексацию сайта в целом, необходимо:

1. Провести техническую оптимизацию сайта.

2. Организовать грамотную структуру сайта.

3. Регулярно добавлять новый качественный материал на сайт.

4. Добавляя новые страницы, нужно сообщать о них ПС.

5. Привлекать на сайт роботов ПС с помощью внешних ссылок.