цод в строительстве что это

Анатомия ЦОДа

Все мы пользуемся облачными сервисами и знаем, что большинство из них доступно благодаря дата-центрам. Что это такое и как выглядит ЦОД внутри? Попробуем заглянуть.

Российские компании настолько активно пользуются услугами центров обработки данных, что сами ЦОДы превратились в отдельный бизнес. Современные дата-центры могут быть гигантскими, чтобы обслуживать корпорации мировых масштабов, или небольшими, но это всегда отдельное сооружение, под завязку заполненное сложнейшими системами, которые интересно рассмотреть поближе.

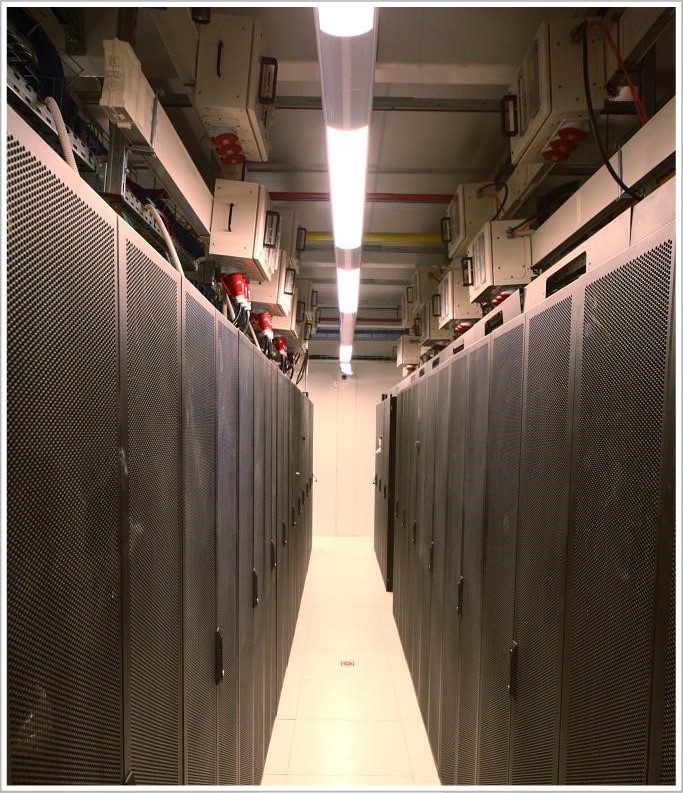

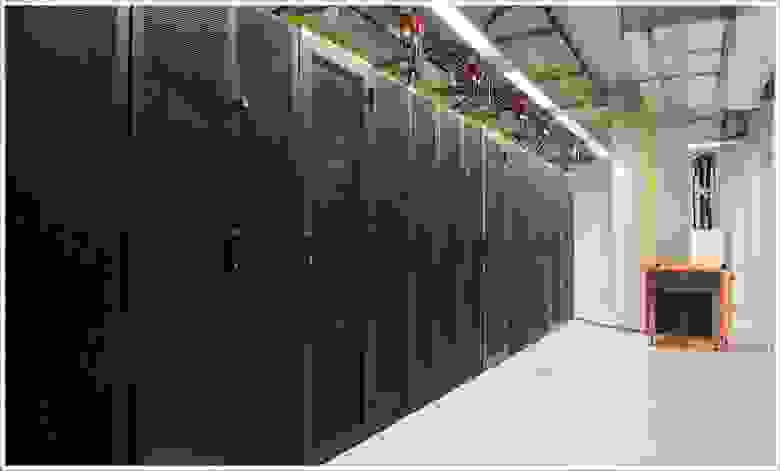

ИТ-инфраструктура

К этому дорогостоящему «железу» совершенно особое отношение: для него создается сложная, дорогая и энергоемкая «обвязка». А всё для того, чтобы эти мощные компьютеры и сетевое оборудование безостановочно работали под нагрузкой в течение нескольких лет. Прежде, чем увидеть работающие серверы, вы их услышите — в серверы устанавливают мощные системы внутренней вентиляции. Как правило, современный сервер имеет один или несколько многоядерных процессоров, большой объем оперативной памяти и несколько высокоскоростных жестких дисков.

Серверы могут быть сконфигурированы с расчетом на выполнение различных задач. Самые популярные сценарии использования — серверы баз данных, почтовые серверы, серверы хранения данных, серверы виртуализации, серверы приложений. От выбранной «специальности» зависит конфигурация оборудования: акцент может быть сделан на скорости обработки данных, на их объеме, на надежности, скорости доступа и т. д.

Для некоторых задач выпускаются специализированные аппаратные решения, такие как супербыстрые системы хранения данных. В последнее время объемы информации так выросли, что классические жесткие диски уже не могут справляться с ними — сказываются ограничения технологий, которые для ряда задач уже можно назвать устаревшими. Поэтому одним из популярных решений становится использование вместо них дисков на основе флэш-памяти. Несколько лет назад флэш-диски были значительно дороже обычных, но сегодня стоимость владения дисковыми массивами по каждой из этих технологий если и различается, то уже не так драматически. При этом у флэш-памяти сохраняются все те плюсы, за которые ее ценят специалисты в области систем хранения данных.

Первая обычно выполняется посредством традиционного коммутационного оборудования, которое не стоило бы упоминания, если бы не одна интересная тенденция последних лет. Как в мире, так уже и в России наметился тренд отхода от классической схемы к программно определяемым решениям. Это не «виртуализация сетей», а серьезный технологический скачок, снимающий ряд существенных требований к коммутационному оборудованию и делающий сети более «умными», а значит — более эффективными. Программно определяемыми могут быть не только сети (SDN), но и хранилища (SDS) и даже весь дата-центр в целом (SDDC).

Кроме того, в дата-центрах используются магистральные линии связи, идущие к телеком-операторам для связи с заказчиками услуг, расположенными вне стен ЦОДа. Как правило, для повышения надежности и доступности современные ЦОДы имеют каналы не к одному, а к двум-трем операторам.

Инженерные системы

Всё вычислительное оборудование в ЦОДе должно непрерывно функционировать, а значит, получать необходимое энергоснабжение, находиться в определенном микроклимате и быть физически защищенным от различных инцидентов.

Поэтому третья обязательная часть ЦОДа — это инженерная инфраструктура.

Инженерные системы включают в себя множество подсистем, в том числе электроснабжение, систему охлаждения, автоматику, комплексную систему безопасности, топливоснабжение и многое другое. Система электроснабжения включает в себя резервные генераторы, источники бесперебойного питания, электрощиты, трансформаторную, шинопроводы. Главная задача энергосистемы — не дать ИТ-оборудованию отключиться в случае пропадания питания от городской сети. Для этого все элементы системы должны иметь резерв, соответствующий требованиям к непрерывной работе ИТ-инфраструктуры в моменты отказов либо регламентных сервисных работ.

Вторая большая задача инженерной инфраструктуры — поддержание в помещениях ЦОДа заданных параметров температуры и влажности. Вычислительное оборудование отдает во внешнюю среду большой объем тепла, которое требуется постоянно отводить из помещения. Если этого не делать, внутрь серверов начинает поступать более горячий воздух и комплектующие перегреваются. Результат — сбои оборудования и потери данных. Во избежание этого в ЦОДе должна быть организована надежная система кондиционирования со всеми резервными компонентами.

Резервирование

Данные должны быть доступны их владельцу в любой момент, они должны быть защищены от повреждения и утраты. Для выполнения этого требования дата-центры резервируют системы — все, что есть: серверное оборудование, коммутаторы, инженерную инфраструктуру и т. д. Обязательным требованием является наличие резервирования уровня N+1 и выше, когда всё активное оборудование и каналы распределения имеют резервирование. Таким образом, любой отказ или сервисные работы не вызывают остановку ЦОДа.

Крупные компании также резервируют и сами дата-центры, строя на достаточно большом расстоянии «клон» основного ЦОДа. Это делается для обеспечения катастрофоустойчивости, чтобы в случае природной или техногенной катастрофы (пожар, землетрясение, бомбардировка, саботаж) второй дата-центр подхватил обязанности первого без потери данных.

Размеры

Его нельзя разместить в комнате бизнес-центра, жилом доме или, например, обычном офисном здании: оборудование не войдет в двери, под его весом провалится пол, ему не хватит энергомощности, высота потолков может не позволить организовать требуемые потоки охлаждения, соседи разбегутся из-за шума и т. д.

Поэтому ЦОДы обычно размещают в специально выделенных зонах. Под крупные и дорогостоящие проекты строятся собственные здания, спроектированные с учетом всех требований стандартов. Бюджетные ЦОДы располагаются в существующих капитальных зданиях. Хорошее решение — это бывший цех в промзоне, где есть и подходящие свободные площади и электромощности. Но иногда под дата-центр можно удачно приспособить даже подземную автомобильную парковку в жилом секторе или разместить его на небольшой площадке во внутреннем дворе предприятия.

Модульный vs. капитальный

Чаще всего ЦОД представляют как капитальное здание, но интерес к такому строительству несколько остыл с началом экономического кризиса. Большинство российских заказчиков оказались в ситуации, когда акционеры требуют максимальной экономии. Поэтому вектор их интереса сместился в направлении модульных дата-центров.

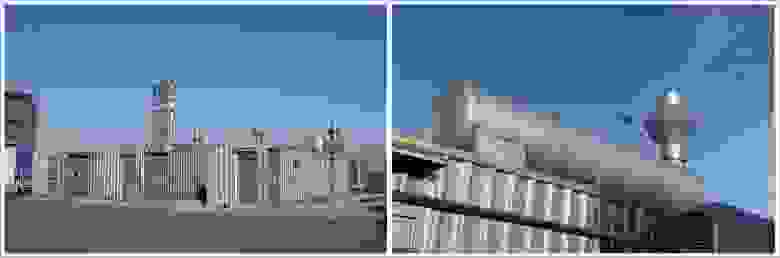

Само название подсказывает, что модульный ЦОД (МЦОД) состоит из нескольких самостоятельных законченных компонентов. Одной из самых надежных технологий создания модульных ЦОДов является технология prefabricated design. Она подразумевает размещение всего инженерного оборудования и коммуникаций в контейнерных модулях, разрабатываемых индивидуально под каждый проект.

При такой разработке обязательно учитываются местные условия — рассчитываются параметры механической конструкции с учетом всех факторов, которые будут на нее влиять: ветер, осадки, уровень влажности, сейсмичность и т. д. Также учитывается масса оборудования, планируемого к установке в МЦОД. Таким образом, МЦОД во многих случаях представляет собой более надежную конструкцию, поскольку его оболочка создается исходя из заданных параметров.

На производственной площадке контейнерные модули собираются в единое целое, образовывая комплекс с несколькими основными технологическими помещениями внутри. После проведения заводских испытаний МЦОД снова разбирается на модули и доставляется на площадку заказчика. При транспортировке всё крупногабаритное инженерное оборудование находится внутри модулей в собранном виде. Процесс финального монтажа решения на площадке напоминает конструктор Lego. «Именно таким образом создавался Республиканский ЦОД (http://www.iksmedia.ru/news/5278383-Modulnyj-CZOD-v-sprinterskom-tempe.html) в Беларуси, построенный компанией SoftLine для крупнейшего белорусского телеком-оператора beCloud: модули были собраны на базе контейнеров на заводе-производителе, протестированы и доставлены на место строительства. Это позволило значительно сократить сроки проекта благодаря распараллеливанию процессов проектирования, строительной подготовки площадки, прокладки внешних сетей и производства модуля ЦОДа на заводе», — говорит Максим Заплёткин, руководитель департамента инженерных решений группы компаний SoftLine.

Такое решение наиболее оптимально для ЦОДов мощностью до 10 МВт ИТ-нагрузки. Если нужен ЦОД для более высокой нагрузки, применяется несколько иная технология: на заводе создаются пространственные конструкции, которые потом транспортируются на площадку заказчика, собираются в единое целое, и только потом внутри монтируются основные инженерные системы. В некоторых случаях можно использовать обе технологии для разных блоков МЦОДа.

Построенный по такой технологии модульный ЦОД — это не «временное решение». Он вполне может заменить капитальный в долгосрочной перспективе. Более того, на модульных решениях можно планировать развитие целой сети ЦОДов для трансрегиональных компаний, поскольку разработанные под их специфические требования модульные конструкции можно использовать как типовые решения. При этом уже на начальном этапе определяется стоимость решения и сроки его реализации с минимальной погрешностью.

Четыре плюса для бизнеса

Второе важное преимущество — более сжатые сроки реализации проекта. Практика показывает, что строительство ЦОДа с использованием модульной технологии prefabricated design занимает примерно в полтора раза меньше времени, чем возведение капитального здания.

Третий аргумент в пользу модульных ЦОДов дают те специалисты, которые знают, насколько важно иметь возможность проведения заводских испытаний всех основных инженерных систем в присутствии заказчика. От ошибок на стадии проектирования не застрахован никто — и они часто случаются. Но такой подход гарантирует отсутствие рисков на стадии монтажных работ на площадке, когда обнаруживается пересечение инженерных коммуникаций на объекте.

Еще к одному из плюсов в пользу модульного решения можно отнести условную «мобильность» МЦОДа с минимальными капитальными потерями. Если потребуется перенести площадку ЦОДа, нужно просто разъединить межмодульные соединения и перевезти модули на новое место. При таком переезде понадобятся затраты только на транспорт, сборку модулей, подключение новых внешних сетей и коммуникаций, что выйдет значительно дешевле, чем капитальные затраты на новую площадку, включающие строительство здания.

Повод построить собственный?

Максим Заплёткин так отвечает на этот вопрос: «Опыт многих заказчиков, которые делали выбор между строительством собственного ЦОДа и арендой серверных стоек в коммерческом ЦОДе, показывает, что в горизонте пяти-семи лет затраты сравниваются. Однако строительство своего ЦОДа — это капитальные затраты, а аренда стоек в коммерческом ЦОДе — операционные. Дать однозначный ответ на этот вопрос невозможно, поскольку принятие решения зависит от того, какой путь выгоден заказчику в долгосрочной перспективе и какой вид затрат более предпочтителен в его бизнес-модели. Можно давать рекомендации, лишь зная особенности бизнеса. Например, ряд компаний имеет внутренние регламенты, которые исключают возможность размещения основных информационных систем в коммерческих ЦОДах. Для таких компаний выбор модульного ЦОДа является, пожалуй, самым оптимальным выбором».

С учетом экономических реалий можно обоснованно предположить, что в ближайшем будущем именно модульные ЦОДы станут одним из наиболее популярных решений для строительства новых центров обработки данных.

ЦОД для технопарка: от «бетона» до сертификации Tier Facility

При строительстве центра технического обеспечения одного из крупнейших российских технопарков я отвечал за инженерную инфраструктуру. Объект седьмым в России прошел сертификацию Tier Facility авторитетного международного института Uptime Institute. О том, чего нам это стоило, какие решения мы использовали и как проходили испытания ЦОД на соответствие международным стандартам, я и расскажу в этом фотопосте.

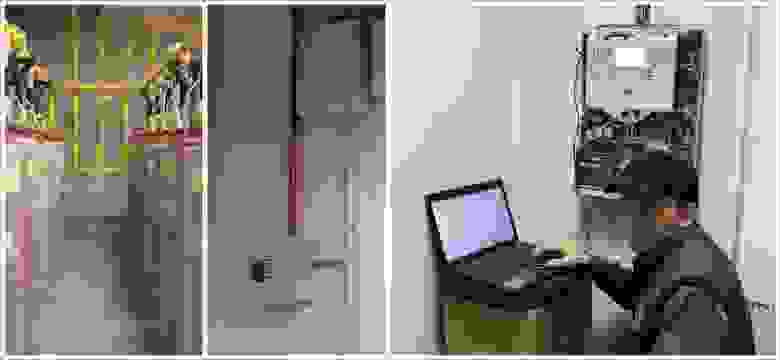

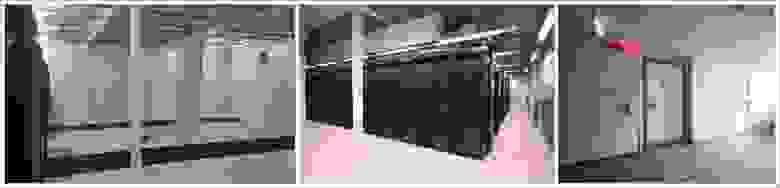

Центр технического обеспечения (ЦТО) технопарка «Жигулевская долина» представляет собой двухэтажное здание. Оно включает шесть машинных залов общей площадью 843 кв. м и вмещает 326 стоек средней мощностью 7 кВт каждая (максимальная нагрузка на стойку – 20 кВт). А мы, специалисты компании «ЛАНИТ-Интеграция», впервые увидели его еще на стадии бетонного каркаса. На тот момент оно не имело никаких коммуникаций. Нам предстояло создать всю инженерную и сетевую инфраструктуру, а также часть вычислительной инфраструктуры для работы автоматики инженерных систем.

Для начала я немного расскажу о проекте в целом, а затем уже покажу всю «начинку».

Итак, в центре технического обеспечения «Жигулевской долины» нужно было установить серверы, СХД и другое оборудование, необходимое резидентам центра инноваций Самарской области. Конечно, для такого оборудования нужны специальные условия эксплуатации: энергообеспечение, тепловой режим, уровень влажности и т. д., поэтому экономически целесообразно было установить оборудование в одном месте.

Мы обследовали здание, изучили имеющуюся у заказчика документацию и приступили к разработке проектной документации (которой предстояло пройти государственную экспертизу). Самая большая сложность заключалась в том, что на разработку проектной и рабочей документации нам отвели всего три месяца. Параллельно с рабочей документацией приходилось готовить часть документации на английском языке для прохождения экспертизы международного института Uptime Institute.

В рамках проекта мы должны были:

Поскольку плотность инженерных систем в ЦОД очень высокая, а сроки сжатые, пришлось детально планировать работы, поставки материалов и оборудования.

Опять же из-за «горящих» сроков решили использовать высокотехнологичные быстровозводимые модульные конструкции – с их помощью избежали дополнительных строительных работ, не делали огнеупорные перегородки и мощную гидроизоляцию. Такое решение защищает помещение от воды, огня, пыли и других опасных для ИТ-оборудования факторов, при этом сборка модульной конструкции занимает всего 1-2 недели.

После экспертизы проекта стали разрабатывать рабочую документацию и заказывать оборудование. Кстати, об оборудовании: поскольку проект попал на кризисный год и возникли сложности с финансированием, нам пришлось всю работу подстраивать под финансовый план и прежде всего остального закупать дорогое крупногабаритное оборудование – цена на него была закреплена производителем.

Изменения в планах поставки оборудования потребовали еще более тщательного планирования. Чтобы организовать работу 100-150 человек на объекте без простоев, проектная команда много внимания уделяла процедурам управления изменениями и управления рисками. Ставку сделали на коммуникации: любая информация о проблемах и задержках практически сразу передавалась по всей цепочке от бригадиров – руководителю проекта и инженерам в головном офисе компании.

Проектная команда и менеджеры закупки трудились в Москве, а основная команда работала непосредственно в технопарке. Инженерам не раз приходилось выезжать в командировку на объект для уточнений и коректировки проектных решенией, а между тем от нашего московского офиса до технопарка по трассе почти 1000 км. Непосредственно на месте мы организовали строительный штаб – там регулярно проходили совещания с участием заказчика и руководителей работ, после которых вся обновленная текущая информация передавалась инженерной команде.

Большинство рабочих специальностей мы набирали в регионе (до 150 человек), что касается узких специалистов и инженеров, их пришлось направить в длительную командировку из Москвы.

В итоге всё получилось. Рассказ о главном испытании – сертификации Uptime Institute – я приберег на самый конец. А сейчас давайте посмотрим, как у нас всё устроено.

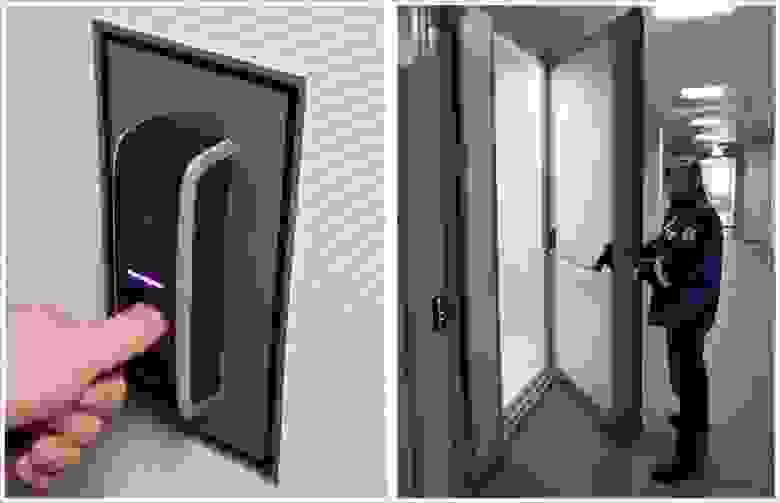

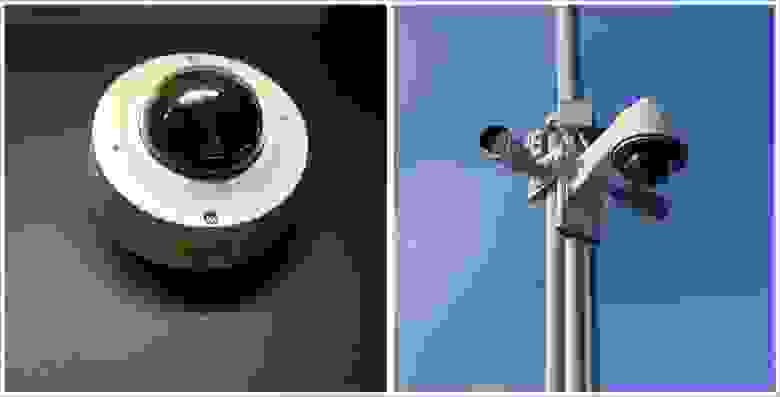

Чтобы попасть в ЦОД, необходимо иметь RFID пропуск и пройти идентификацию на входе на территорию ЦОДа. В здании также все двери под контролем, в некоторые залы действует допуск только после двойной идентификации сотрудника.

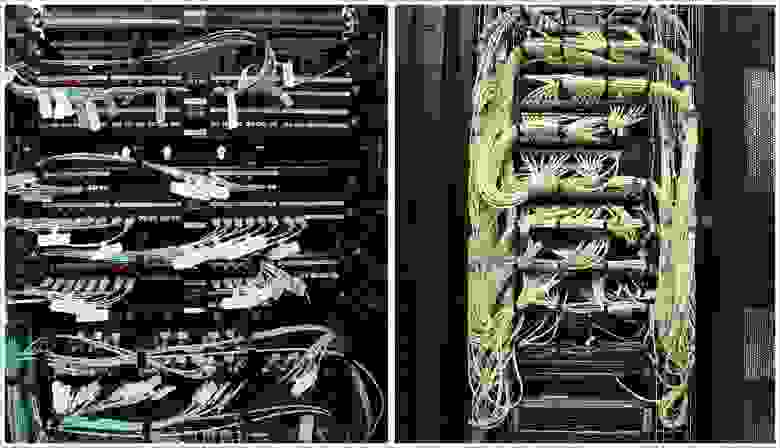

Структурированные кабельные системы

Для сети передачи данных мы использовали коммутаторы HP FlexFabric и Juniper QFabric. Интеллектуальная СКС Panduit с системой управления физической инфраструктурой PanView iQ позволяет удаленно контролировать и автоматически документировать состояние физического уровня сети, а также осуществлять интеллектуальное управление полем коммутации.

Возможно контролировать правильность подключения оборудования или нештатного подключения к портам СКС. Претерминированные кабели позволяют при необходимости менять конфигурацию СКС на тех участках, где это требуется.

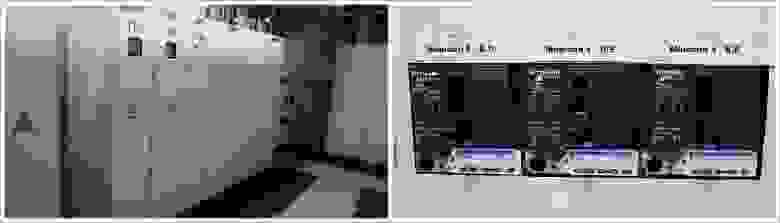

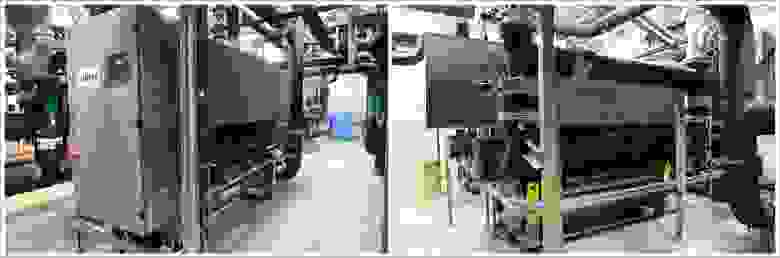

Электроснабжение ЦОД

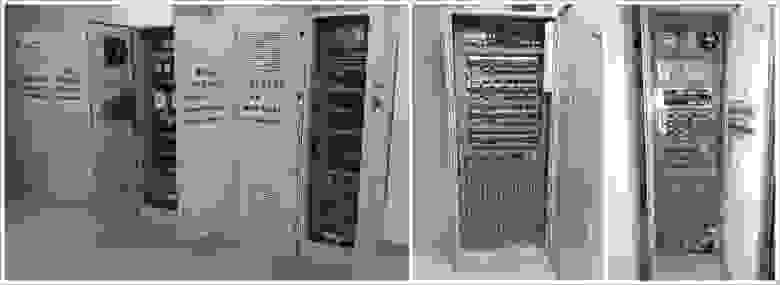

В собственной трансформаторной подстанции станции ЦТО установлено 4 независимых трансформатора, которые питают электроэнергией вводно-распределительные устройства (ВРУ1-4) ЦТО.

Суммарная выделенная мощность на ЦОД – 4,7 МВт.

От трансформаторной подстанции в ВРУ ЦТО отходят 8 независимых лучей и через систему гарантированного питания на базе дизельно-роторных источников бесперебойного питания (ДДИБП) питают 8 ВРУ ЦОД, 4 ВРУ системы бесперебойного питания и 4 ВРУ системы гарантированного питания. Система питания построена по схеме 2N, кабели заходят с двух разных сторон здания ЦОД в две разнесенные электрощитовые.

Схема 2N реализует резервирование по электроснабжению. Любой питающий луч для обслуживания может быть выведен из работы, при этом ЦОД будет полностью работоспособен.

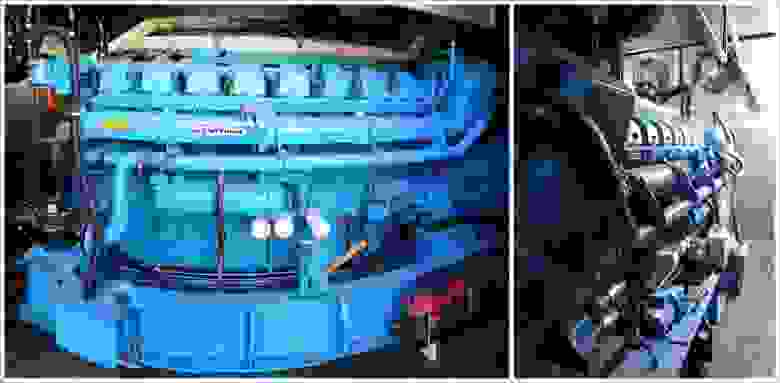

Для бесперебойного и гарантированного электроснабжения мы установили дизель-динамические источники бесперебойного питания Piller. Мощность каждого 1МВт бесперебойного и 650 кВт гарантированного питания, что позволяет обеспечить работу ЦОД в полном объеме.

В случае прекращения поступления электроэнергии ротор вращается по инерции и электрическая установка продолжает вырабатывать ток еще несколько секунд. Этого небольшого промежутка времени хватает на запуск дизель-генератора и выхода на рабочие обороты. Таким образом, работа оборудования не прекращается ни на секунду.

Схема построения N+1. При такой мощности вырабатываемой электроэнергии дизельный двигатель имеет большой расход топлива – более 350 литров в час, что потребовало дополнительного внешнего топливохранилища объемом более 100 тонн дизельного топлива.

В здании ЦОД две разнесенные электрощитовые. В каждой установлено по 2 ВРУ системы бесперебойного питания и 2 ВРУ системы гарантированного питания.

Система диспетчеризации контролирует состояние всех автоматических выключателей. Также установлены приборы технологического учета, что позволяет контролировать потребление электроэнергии по каждому направлению электропитания. Для обеспечения бесперебойной работы вспомогательных систем установлен шкаф со статическим электронным байпасом.

Система распределения также контролируется системой диспетчеризации, и каждая линия оснащена прибором технологического учета.

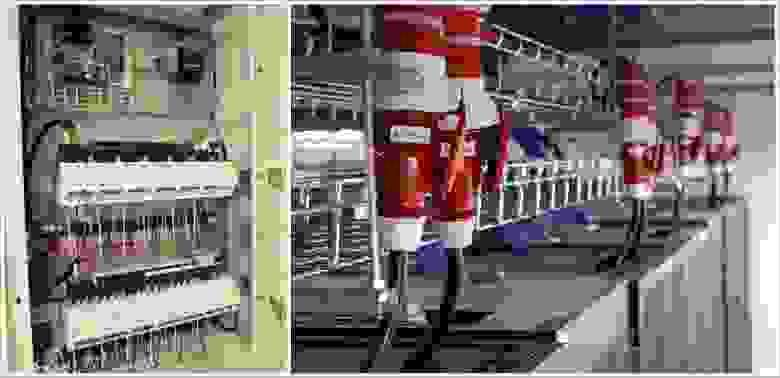

В малых залах размещены шкафы распределения, от них отходят линии к каждому серверному шкафу, в котором установлено по два блока распределения питания.

В больших залах для распределения электроснабжения был использован шинопровод. В отводных коробках каждый автомат также контролируется системой диспетчеризации, что позволяет постоянно получать полную картину о работе системы электроснабжения ЦОД.

Непосредственно в серверных шкафах для распределения электроэнергии установлены блоки распределения питания.

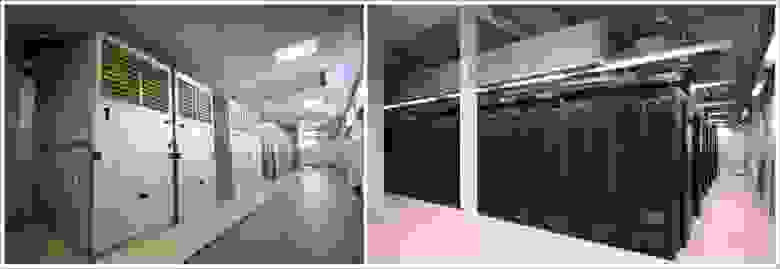

Охлаждение залов

На первом этаже в аппаратных и машинных залах ЦТО оборудование охлаждается с применением внутрирядных прецизионных кондиционеров Emerson (ранее приобретенных заказчиком) и с использованием водяных чиллеров и драйкулеров для подготовки захоложенной воды.

Для охлаждения залов второго этажа (с основной нагрузкой) мы применили кондиционеры с рекуператором воздух-воздух.

В четырех машинных залах второго этажа развернута инновационная система охлаждения от компании AST Modular, включающая в себя 44 модуля охлаждения наружным воздухом Natural Free Cooling.

Система представляет собой два разомкнутых контура. В одном из них циркулирует воздух из машинного зала, а в другой через систему технологической вентиляции подается прохладный воздух с улицы. Оба потока проходят через рекуперативный теплообменник, в котором происходит теплообмен между наружным и внутренним воздухом. Таким образом, оборудование может охлаждаться наружным воздухом до 90% времени в году, что позволяет на 20-30% снизить затраты на традиционное активное охлаждение с использованием водяных чиллеров и драйкулеров. Летом охлаждение воздуха производится захоложеной водой от чиллеров.

К началу проекта у нас уже был опыт создания подобных систем охлаждения: Natural Fresh Aircooling мы использовали в высокотехнологичном модульном ЦОДе «ВымпелКома» в Ярославле. Но каждый новый проект таит свои сложности.

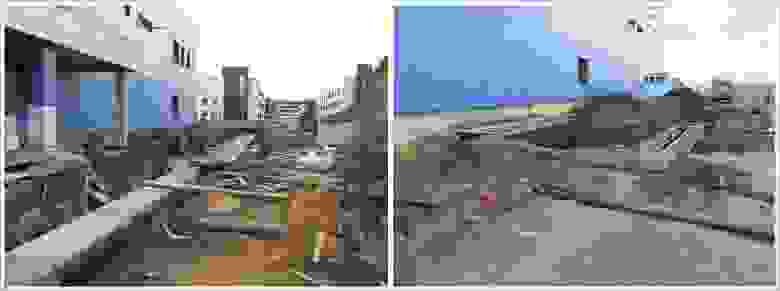

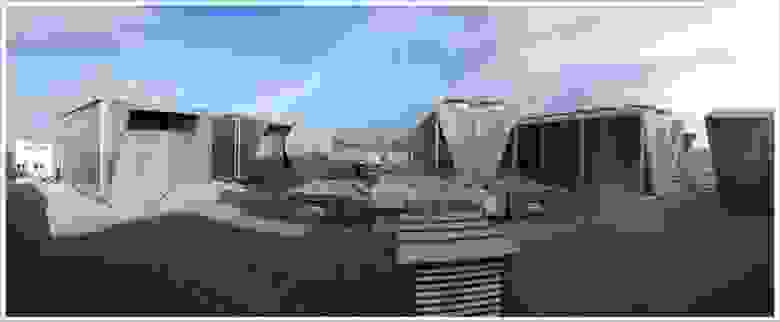

Хладоцентр на первом этаже и оборудование на крыше

В помещении хладоцентра (ХЦ) разместили чиллерные машины, насосные группы, теплообменики и т.д.

Водяные чиллеры и драйкулеры используются для подачи захоложенной воды в установки Natural Free Cooling на втором этаже в жаркое время года и в кондиционеры на первом этаже постоянно. Зимой охлаждение воды осуществляется через теплообменник в ХЦ и градирни на крыше, что также позволяет не включать чиллеры и экономить электроэнергию.

По проекту, большой объем оборудования нам нужно было установить на крыше ЦТО, поэтому пришлось практически построить третий этаж в виде стотонной рамы и установить на нее около 60 тонн оборудования: градирни, длина которых достигала 14 м, и мощные вентустановки выше человеческого роста.

С градирнями мы, конечно, попотели: попробуй подними такую громадину на крышу! Из-за больших габаритов оборудования пришлось варить специальную балку для разгрузки, а также использовать кран грузоподъемностью 160 т с большой стрелой, и даже такой кран местами проседал.

Пожарная безопасность

Для пожарной безопасности на площадке развернуты системы пожарной сигнализации, раннего обнаружения пожара (аспирационная система – датчики, анализирующие состав воздуха), автоматического газового пожаротушения и система газоудаления, которая позволяет удалять остатки газа после отработки системы пожаротушения.

Система оповещения о пожаре работает следующим образом: пожарные датчики машинных залов, аппаратных, а также вспомогательных помещений выдают соответствующие сигналы на центральную станцию автоматической пожарной сигнализации, которая, в свою очередь, запускает систему автоматического газового пожаротушения, пожарную автоматику и систему оповещения, в зависимости от зоны возникновения пожара.

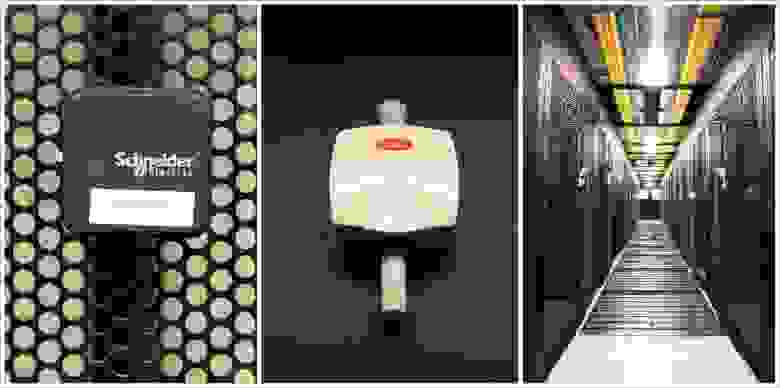

В качестве основного было использовано оборудование ESMI (Schneider Electric). Оно закрыло все задачи по обеспечению пожарной безопасности и отображается на рабочей станции оператора в диспетчерской.

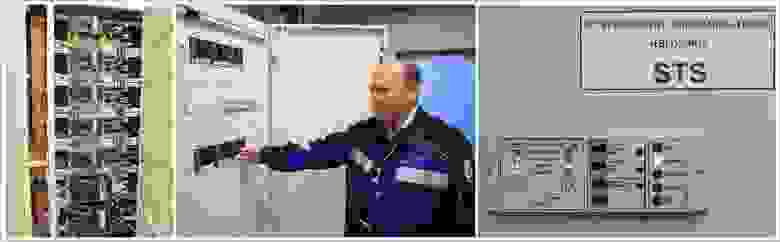

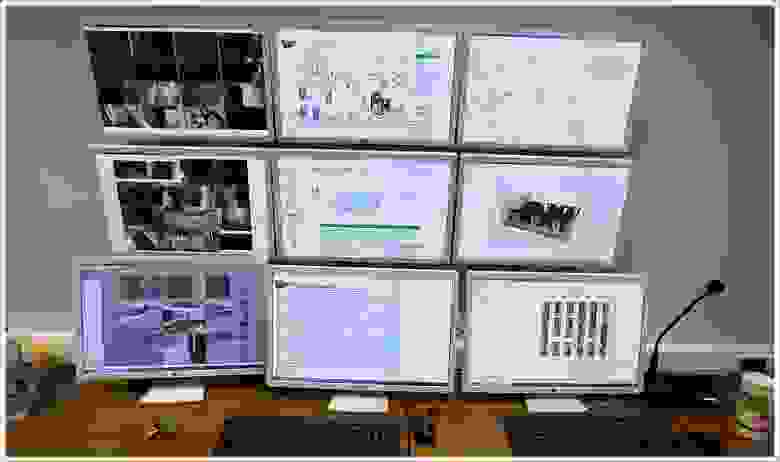

Система автоматизации и диспетчеризации ЦОД

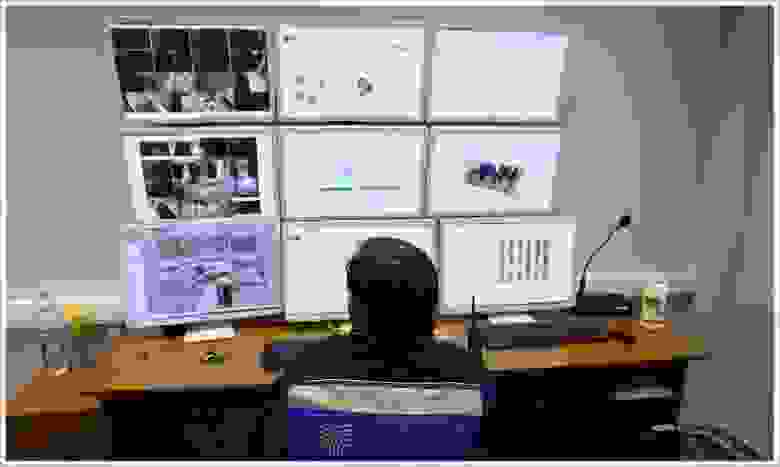

В большинстве ЦОД ставят только локальную автоматизацию с минимальным набором функций мониторинга, а у нас все подсистемы интегрированы в единое техническое решение с общей системой контроля. Система контроля отслеживает состояние более 10 систем и выводит более 20 тыс. параметров. Хотите узнать температуру и влажность в машинных залах или вас интересует потребление электроэнергии по каждой ИТ-стойке? Без проблем.

В рамках системы мониторинга и диспетчеризации мы использовали как SCADA-систему, так и систему мониторинга и менеджмента ЦОД. SCADA-система (Supervisory Control And Data Acquisition — диспетчерское управление и сбор данных) позволяет просматривать данные и управлять автоматикой установленного оборудования: чиллера, кондиционера, дизельно-роторных ИБП, вентиляции, насосов и т.д.

Система учета ресурсов дата-центра позволяет вести полный учет всего оборудования, установленного в стойках. Она в реальном времени отображает аварийные сообщения, данные о состоянии оборудования с визуализацией на детальном плане размещения. Благодаря детализации мы можем увидеть любое устройство, расположенное в ЦОД.

Система позволяет моделировать аварийные ситуации и выдает рекомендации по решению проблем, а также позволяет планировать и оптимизировать эксплуатацию технических ресурсов ЦОД.

Здесь также ведется контроль и управление вентиляционными системами (в том числе контроль температуры подаваемого ими воздуха, так они участвуют в технологическом процессе охлаждения ИТ-оборудования). Учитываются все параметры по кондиционерам, вентиляционным установкам и системам холодоснабжения.

Система отслеживает состояние оборудования и управляет им (и различными клапанами). Кроме того, она дополнительно защищает оборудование от критических режимов.

Система контролирует состояние всех основных аппаратов защиты в электрошкафах, а также электропотребление на данных линиях.

Система позволяет вести учет установленного оборудования в ИТ-стойках, а также хранить информацию о его принадлежности. Сюда стекаются данные с противопожарных систем и системы безопасности здания.

Управление зданием осуществляется при помощи решений, построенных на оборудовании компании Schneider Electric. Автоматизированная система диспетчеризации, мониторинга и управления инженерными системами предоставляет всю необходимую информацию диспетчеру на его рабочем месте.

Системы связаны между собой посредством технологического сегмента сети передачи данных. Программное обеспечение установлено на виртуальных машинах, обеспечено резервное копирование данных.

Для обеспечения безопасности, видеонаблюдения и контроля доступа в ЦОД также было установлено централизованное решение Schneider Electric. Оно выдает необходимую информацию в систему диспетчеризации ЦОД.

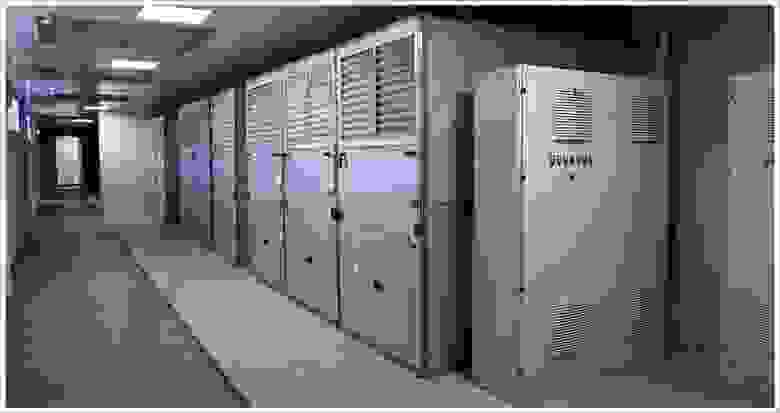

Всё оборудование, о котором я рассказал, собрано в отказоустойчивой конфигурации и размещено в модульных помещениях Smart Shelter, обеспечивающих надежную защиту ЦТО от пожара, влаги, вибрации и других внешних воздействий. Данное решение позволило сократить срок реализации проекта. На сборку одного помещения в среднем ушло две недели.

Пройти огонь, воду и… экзамен Uptime Institute

Чтобы сдать экзамен на соответствие ЦОД стандартам Tier III Design и Tier III Facility, нам пришлось выполнить всю документацию согласно требованиям Uptime Institute, пройти ее сертификацию и по этой документации смонтировать и запустить все системы. В финале мы выдержали тестирование систем дата-центра на соответствие Tier III Facility. А это порядка 50 тестов!

Подготовка к испытаниям оказалась непростой: если сертификация документации понятна, то найти информацию, как проходит сертификация самого объекта, было крайне сложно (на тот момент ЦОД «Жигулевской долины» оказался седьмым в России дата-центром, проходящим сертификацию).

Много сил ушло на внутренний аудит (испытания под нагрузкой уже ранее проводились для заказчика). Две недели мы друг за другом все проверяли в соответствии с проектной документации и тестами, полученными от Uptime Institute, и все равно, конечно же, нервничали во время сертификации.

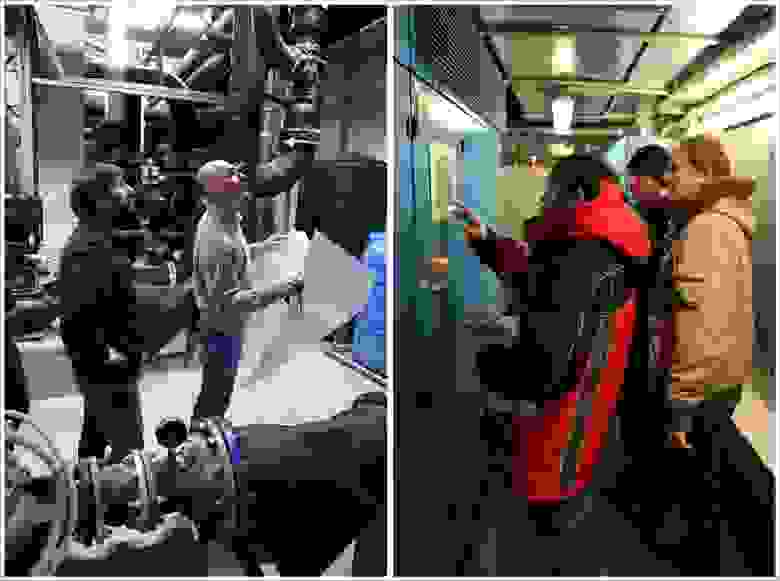

Когда специалисты Uptime Institute приехали в ЦОД с инспекцией и стали осматривать залы, я для себя на будущее сделал важный вывод – в команде должен быть один лидер, который возьмет на себя общение с «экзаменаторами». О том, кто станет таким человеком, нужно подумать еще на этапе формирования команды. Мы постарались именно так и сделать, и все же в процессе испытаний некоторые наши сотрудники пытались проявить инициативу. Представители Uptime Institute, замечая сторонние обсуждения, сразу же задавали дополнительные вопросы.

Первый день был ознакомительным: инспектор осматривал ЦОД на соответствие проектной документации.

На следующий день для ключевого тестирования Uptime Institute нужно было дать полную нагрузку ЦОД – как тепловую, так и в части энергопотребления. Нагрузку имитировали специально установленные тепловые пушки мощностью 30-100 кВт.

Для некоторых тестов оборудование переводилось в критический режим, и были опасения, что системы не выдержат. Чтобы обезопасить оборудование от возможных последствий (как говорится, береженого Бог бережет), мы пригласили инженеров со стороны производителей оборудования.

За всем происходящим из диспетчерской в режиме реального времени наблюдал один из инспекторов Uptime Institute – Фред Дикерман. Автоматизированная система диспетчерского управления и множество датчиков позволяли отслеживать текущее состояние оборудования и изменение температур в машинных залах.

Результаты сертификации показали, что мы изначально заложили верные технические решения, все корректно смонтировали и запустили. Со слов экспертов, данный ЦОД оказался единственным в России, который прошел проверку Uptime Institute без замечаний.

А напоследок – видеоролик о нашем проекте в «Жигулевской долине»