чем больше энтропия тем

Энтропия — это свойство не системы, а нашего знания об этой системе

Этот пост является вольным переводом ответа, который Mark Eichenlaub дал на вопрос What’s an intuitive way to understand entropy?, заданный на сайте Quora

Энтропия. Пожалуй, это одно из самых сложных для понимания понятий, с которым вы можете встретиться в курсе физики, по крайней мере если говорить о физике классической. Мало кто из выпускников физических факультетов может объяснить, что это такое. Большинство проблем с пониманием энтропии, однако, можно снять, если понять одну вещь. Энтропия качественно отличается от других термодинамических величин: таких как давление, объём или внутренняя энергия, потому что является свойством не системы, а того, как мы эту систему рассматриваем. К сожалению в курсе термодинамики её обычно рассматривают наравне с другими термодинамическими функциями, что усугубляет непонимание.

Так что же такое энтропия?

Если в двух словах, то

Энтропия — это то, как много информации вам не известно о системе

Например, если вы спросите меня, где я живу, и я отвечу: в России, то моя энтропия для вас будет высока, всё-таки Россия большая страна. Если же я назову вам свой почтовый индекс: 603081, то моя энтропия для вас понизится, поскольку вы получите больше информации.

Почтовый индекс содержит шесть цифр, то есть я дал вам шесть символов информации. Энтропия вашего знания обо мне понизилась приблизительно на 6 символов. (На самом деле, не совсем, потому что некоторые индексы отвечают большему количеству адресов, а некоторые — меньшему, но мы этим пренебрежём).

Или рассмотрим другой пример. Пусть у меня есть десять игральных костей (шестигранных), и выбросив их, я вам сообщаю, что их сумма равна 30. Зная только это, вы не можете сказать, какие конкретно цифры на каждой из костей — вам не хватает информации. Эти конкретные цифры на костях в статистической физике называют микросостояниями, а общую сумму (30 в нашем случае) — макросостоянием. Существует 2 930 455 микросостояний, которые отвечают сумме равной 30. Так что энтропия этого макросостояния равна приблизительно 6,5 символам (половинка появляется из-за того, что при нумерации микросостояний по порядку в седьмом разряде вам доступны не все цифры, а только 0, 1 и 2).

А что если бы я вам сказал, что сумма равна 59? Для этого макросостояния существует всего 10 возможных микросостояний, так что его энтропия равна всего лишь одному символу. Как видите, разные макросостояния имеют разные энтропии.

Пусть теперь я вам скажу, что сумма первых пяти костей 13, а сумма остальных пяти — 17, так что общая сумма снова 30. У вас, однако, в этом случае имеется больше информации, поэтому энтропия системы для вас должна упасть. И, действительно, 13 на пяти костях можно получить 420-ю разными способами, а 17 — 780-ю, то есть полное число микросостояний составит всего лишь 420х780 = 327 600. Энтропия такой системы приблизительно на один символ меньше, чем в первом примере.

Мы измеряем энтропию как количество символов, необходимых для записи числа микросостояний. Математически это количество определяется как логарифм, поэтому обозначив энтропию символом S, а число микросостояний символом Ω, мы можем записать:

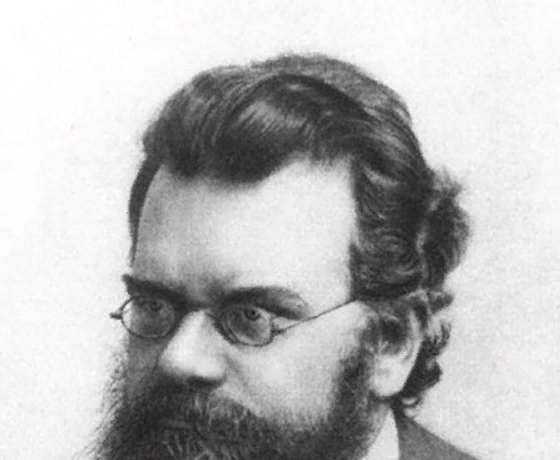

Это есть ничто иное как формула Больцмана (с точностью до множителя k, который зависит от выбранных единиц измерения) для энтропии. Если макросостоянию отвечают одно микросостояние, его энтропия по этой формуле равна нулю. Если у вас есть две системы, то полная энтропия равна сумме энтропий каждой из этих систем, потому что log(AB) = log A + log B.

Из приведённого выше описания становится понятно, почему не следует думать об энтропии как о собственном свойстве системы. У системы есть опеделённые внутренняя энергия, импульс, заряд, но у неё нет определённой энтропии: энтропия десяти костей зависит от того, известна вам только их полная сумма, или также и частные суммы пятёрок костей.

Другими словами, энтропия — это то, как мы описываем систему. И это делает её сильно отличной от других величин, с которыми принято работать в физике.

Физический пример: газ под поршнем

Классической системой, которую рассматривают в физике, является газ, находящийся в сосуде под поршнем. Микросостояние газа — это положение и импульс (скорость) каждой его молекулы. Это эквивалентно тому, что вы знаете значение, выпавшее на каждой кости в рассмотренном раньше примере. Макросостояние газа описывается такими величинами как давление, плотность, объём, химический состав. Это как сумма значений, выпавших на костях.

Величины, описывающие макросостояние, могут быть связаны друг с другом через так называемое «уравнение состояния». Именно наличие этой связи позволяет, не зная микросостояний, предсказывать, что будет с нашей системой, если начать её нагревать или перемещать поршень. Для идеального газа уравнение состояния имеет простой вид:

хотя вы, скорее всего, лучше знакомы с уравнением Клапейрона — Менделеева pV = νRT — это то же самое уравнение, только с добавлением пары констант, чтобы вас запутать. Чем больше микросостояний отвечают данному макросостоянию, то есть чем больше частиц входят в состав нашей системы, тем лучше уравнение состояния её описывают. Для газа характерные значения числа частиц равны числу Авогадро, то есть составляют порядка 1023.

Величины типа давления, температуры и плотности называются усреднёнными, поскольку являются усреднённым проявлением постоянно сменяющих друг друга микросостояний, отвечающих данному макросостоянию (или, вернее, близким к нему макросостояниям). Чтобы узнать в каком микросостоянии находится система, нам надо очень много информации — мы должны знать положение и скорость каждой частицы. Количество этой информации и называется энтропией.

Как меняется энтропия с изменением макросостояния? Это легко понять. Например, если мы немного нагреем газ, то скорость его частиц возрастёт, следовательно, возрастёт и степень нашего незнания об этой скорости, то есть энтропия вырастет. Или, если мы увеличим объём газа, отведя поршень, увеличится степень нашего незнания положения частиц, и энтропия также вырастет.

Твёрдые тела и потенциальная энергия

Если мы рассмотрим вместо газа какое-нибудь твёрдое тело, особенно с упорядоченной структурой, как в кристаллах, например, кусок металла, то его энтропия будет невелика. Почему? Потому что зная положение одного атома в такой структуре, вы знаете и положение всех остальных (они же выстроены в правильную кристаллическую структуру), скорости же атомов невелики, потому что они не могут улететь далеко от своего положения и лишь немного колеблются вокруг положения равновесия.

Если кусок металла находится в поле тяготения (например, поднят над поверхностью Земли), то потенциальная энергия каждого атома в металле приблизительно равна потенциальной энергии других атомов, и связанная с этой энергией энтропия низка. Это отличает потенциальную энергию от кинетической, которая для теплового движения может сильно меняться от атома к атому.

Если кусок металла, поднятый на некоторую высоту, отпустить, то его потенциальная энергия будет переходить в кинетическую энергию, но энтропия возрастать практически не будет, потому что все атомы будут двигаться приблизительно одинаково. Но когда кусок упадёт на землю, во время удара атомы металла получат случайное направление движения, и энтропия резко увеличится. Кинетическая энергия направленного движения перейдёт в кинетическую энергию теплового движения. Перед ударом мы приблизительно знали, как движется каждый атом, теперь мы эту информацию потеряли.

Понимаем второй закон термодинамики

Второй закон термодинамики утверждает, что энтропия (замкнутой системы) никогда не уменьшается. Мы теперь можем понять, почему: потому что невозможно внезапно получить больше информации о микросостояниях. Как только вы потеряли некую информацию о микросостоянии (как во время удара куска металла об землю), вы не можете вернуть её назад.

Давайте вернёмся обратно к игральным костям. Вспомним, что макросостояние с суммой 59 имеет очень низкую энтропию, но и получить его не так-то просто. Если бросать кости раз за разом, то будут выпадать те суммы (макросостояния), которым отвечает большее количество микросостояний, то есть будут реализовываться макросостояния с большой энтропией. Самой большой энтропией обладает сумма 35, и именно она и будет выпадать чаще других. Именно об этом и говорит второй закон термодинамики. Любое случайное (неконтролируемое) взаимодействие приводит к росту энтропии, по крайней мере до тех пор, пока она не достигнет своего максимума.

Перемешивание газов

И ещё один пример, чтобы закрепить сказанное. Пусть у нас имеется контейнер, в котором находятся два газа, разделённых расположенной посередине контейнера перегородкой. Назовём молекулы одного газа синими, а другого — красными.

Если открыть перегородку, газы начнут перемешиваться, потому что число микросостояний, в которых газы перемешаны, намного больше, чем микросостояний, в которых они разделены, и все микросостояния, естественно, равновероятны. Когда мы открыли перегородку, для каждой молекулы мы потеряли информацию о том, с какой стороны перегородки она теперь находится. Если молекул было N, то утеряно N бит информации (биты и символы, в данном контексте, это, фактически, одно и тоже, и отличаются только неким постоянным множителем).

Разбираемся с демоном Максвелла

Ну и напоследок рассмотрим решение в рамках нашей парадигмы знаменитого парадокса демона Максвелла. Напомню, что он заключается в следующем. Пусть у нас есть перемешанные газы из синих и красных молекул. Поставим обратно перегородку, проделав в ней небольшое отверстие, в которое посадим воображаемого демона. Его задача — пропускать слева направо только красных, и справа налево только синих. Очевидно, что через некоторое время газы снова будут разделены: все синие молекулы окажутся слева от перегородки, а все красные — справа.

Получается, что наш демон понизил энтропию системы. С демоном ничего не случилось, то есть его энтропия не изменилась, а система у нас была закрытой. Получается, что мы нашли пример, когда второй закон термодинамики не выполняется! Как такое оказалось возможно?

Решается этот парадокс, однако, очень просто. Ведь энтропия — это свойство не системы, а нашего знания об этой системе. Мы с вами знаем о системе мало, поэтому нам и кажется, что её энтропия уменьшается. Но наш демон знает о системе очень много — чтобы разделять молекулы, он должен знать положение и скорость каждой из них (по крайней мере на подлёте к нему). Если он знает о молекулах всё, то с его точки зрения энтропия системы, фактически, равна нулю — у него просто нет недостающей информации о ней. В этом случае энтропия системы как была равна нулю, так и осталась равной нулю, и второй закон термодинамики нигде не нарушился.

Но даже если демон не знает всей информации о микросостоянии системы, ему, как минимум, надо знать цвет подлетающей к нему молекулы, чтобы понять, пропускать её или нет. И если общее число молекул равно N, то демон должен обладать N бит информации о системе — но именно столько информации мы и потеряли, когда открыли перегородку. То есть количество потерянной информации в точности равно количеству информации, которую необходимо получить о системе, чтобы вернуть её в исходное состояние — и это звучит вполне логично, и опять же не противоречит второму закону термодинамики.

# чтиво | Энтропия растет с течением времени или создает его?

Вопрос будет следующим:

«Допустим, энтропия — это мера беспорядка объектов. Но что в ней такого важного, что она должна быть законом?».

Если вы посмотрите почти на все законы физики, время будет течь почти с опозданием. Сделайте фильм из столкновения двух электронов, а потом запустите фильм в обратном порядке, и вторая версия будет выглядеть так же нормально и физически достоверно, как и первый вариант. На микроскопическом уровне время кажется практически симметричным. Потому что, как мы писали, на этом уровне не работает привычная нам термодинамика.

На макроскопическом уровне все совершенно иначе. Вы не помните будущее, например, не можете склеить яйцо или разделить коктейль на составляющие. И говоря о возможности путешествий во времени, мы подразумеваем только одну стрелу времени, один вектор, одно направление: вперед.

Есть один общий знаменатель, отличающий будущее от прошлого: все запутывается. Вы знаете это как «второй закон термодинамики». Или не знаете. Мне все равно.

Второй закон гласит, буквально, что все разваливается, или что вещи становятся все более и более хаотичными и беспорядочными со временем, но это не совсем так. Правильно так: полная энтропия замкнутой системы возрастает со временем. Энтропия является мерой числа способов, которыми вы можете переворачивать вещи с ног на голову и сохранять все макроскопические величины неизменными.

Весьма школьный пример

В любой момент времени вы будете видеть случайный снимок трех молекул. Есть восемь разных путей организовать молекулы, но только два из них (ЛЛЛ, ППП) разместят все три молекулы в одной части контейнера. Это всего лишь 25 % вероятности. В остальное время атомы, скорее всего, будут распределены равномерно. И равномерное распределение — это более высокое состояние энтропии, чем концентрированное.

Вы можете играть в эту же игру, набрав полную ладонь монет и подбрасывая их в воздух. Орел и решка — это правая и левая часть коробки, и наоборот. Проделайте этот жест несколько раз и увидите, что молекулы почти всегда равномерно распределяются.

Большие числа превращают вероятность в закон

Если вы увеличите число молекул воздуха, к примеру, до 10 26 или выше, вероятность подсказывает, что случайные движения в итоге распределят молекулы «равномерно». Благодаря квантовой механике, случайность становится принципиальной составляющей всего этого. То есть, поскольку есть техническая вероятность того, что все молекулы воздуха внезапно покинут вашу спальню, пока вы спите, за несколько минут, это явно не то, чего стоит бояться ночью.

Растущая энтропия — на самом деле закон, поскольку во Вселенной так много частиц, что вероятность того, что все они спонтанно выстроятся в состояние низкой энтропии, ошеломляюще мала. Этот же тип случайно работает в отношении азартных игр и прогнозирования погоды.

Ну или еще пример. Вам выпадает решка два раза подряд, и вы совсем не удивляетесь этому. Но если кому-то решка выпадает сто раз кряду, это становится подозрительным. Чтобы оценить масштаб такого события, представьте себе: если вы будете подбрасывать монетку 10 раз в секунду, у вас уйдет времени в триллион раз больше нынешнего возраста вселенной, прежде чем вы дождетесь результата. Грубо говоря, в определенный момент система становится настолько большой, что шанс на то, что энтропия будет уменьшаться, не просто мал, но крайне близок к нулю. Поэтому мы называем это «вторым законом».

Креационисты среди вас могут использовать это как доказательство, что сложные вещи (вроде людей или динозавров) никогда не смогли бы сформироваться. В конце концов, вы ведь высоко упорядоченный человек, стоит полагать. Если вы облако газа, примите мои извинения. Но если предположить, что вы человек, нет ничего странного в том, что вы существуете как маленький шанс высокого порядка.

Суть правила в том, что энтропия растет во всей вселенной. Например, если вы сделаете хорошенький холодильник, полный холодного воздуха, вы сделаете это за счет высокой энтропии горячего воздуха. Вот почему кондиционер нуждается в выхлопе, а обогреватель — нет. По этой же причине вы не можете построить вечный двигатель. Часть энергии всегда будет преобразовываться в тепло.

Энтропия непрерывно увеличивается со временем. Вы сидите в горячей ванне в прохладной комнате, чувствуете себя тепло и уютно, но потом события начинают принимать угрожающий поворот: вода в номере по температуре приближается к воздуху, вам становится холодно, вас атакуют мурашки.

То же самое касается будущего Вселенной. С течением времени тепло равномерно распределится во Вселенной. Звезды выгорят, черные дыры испарятся, станет темно и холодно. Бум.

Время и второй закон

Одной из причин, почему вообще эти идеи набирают обороты, является загадка наблюдателя. Юная вселенная, судя по всему, находилась в состоянии высокого порядка, но нет никаких фундаментальных причин, почему это должно быть так. Вселенная, созданная сразу после Большого Взрыва, должна была бы находиться в состоянии полного хаоса, но вместо этого она была невероятно упорядоченной. Гравитационная система высокой энтропии свернулась в комки (произведя звезды, галактики и черные дыры), но вселенная была гладкой. Почему?

Другие заходят еще дальше. Эрик Верлинде, например, утверждает, что такие явления, как гравитация, вытекают из второго закона термодинамики (и теории струн). Стоит отметить, что интересных идей много. Многие говорят, что время заставляет энтропию расти, но не энтропия порождает время. Для кого-то энтропия это просто то, что происходит.

Или должно произойти с высокой вероятностью.

Энергия и энтропия

Эта статья является конспектом материала посвященного энергии и энтропии из книги «Битва при черной дыре».

Рассмотрим пример. Поднятие массивного объекта, например, камня на возвышенность. Прежде чем приступать к поднятию, можно подкрепиться едой. После поднятия камня отпускаем его и под действием гравитации он скатывается вниз. Следовательно, химическая энергия (еда) превращается в потенциальную энергию, а затем в кинетическую. Но что же происходит с кинетической энергией, когда камень скатился и остановился? Она превращается в тепловую, часть из которой ушла в атмосферу, часть – в землю. Полный цикл: химическая => потенциальная => кинетическая => тепловая.

Эйнштейн показал, что масса – это энергия. Утверждая это, он имел в виду, что каждый предмет содержит скрытую энергию, которую можно извлечь при изменении его массы. Например, ядро урана спонтанно распадается на ядро тория и гелия. Вместе они весят чуть меньше, чем исходный уран. Этот избыток массы превращается в кинетическую энергию ядер тория и гелия, а также в несколько фотонов. Когда атомы замедляются, а фотоны поглощаются, избыток энергии становится теплом.

Из всех самой загадочной выглядит тепловая энергия. До появления современной молекулярной теории теплоты физики и химики считали ее субстанцией, поведение которой похоже на жидкость. Представляли, что она перетекает от горячих объектов к холодным, охлаждая горячие и нагревая холодные.

Но тепло – это форма энергии. Чтобы это представить, давайте проведем мысленный эксперимент. Если сжаться до размеров молекулы в горячей воде, то можно увидеть, как молекулы воды хаотично и быстро сталкиваются друг с другом. Если вода начнет остывать, то молекулы станут двигаться медленнее. Если охладить до точки замерзания, то молекулы соединяться в кристалл твердого тела. Но даже в этом случае они колеблются. В случае отведения всей энергии молекулы прекращают колебаться (если не брать в счет квантовые флуктуации) и в этом случае температура достигнет абсолютного нуля по Кельвину или минус 273,15 градуса по Цельсию.

Принцип сохранения энергии при ее превращениях между разными формами называется первым началом термодинамики.

Энтропия

Представим ржавление машины со временем. Рано или поздно если ее не трогать, она вся превратится в кучу ржавчины. Однако она никогда не превратится обратно в работающую машину. Это и есть рост энтропии. Второе начало термодинамики говорит, что энтропия постоянно возрастает. Но что же это такое? Рассмотрим разницу между рабочей машиной и кучей ржавчины, которая когда-то была ей. То и другое состоит примерно из одинакового количества атомов. Представим, что случайным образом перемешиваются эти атомы. Шансы того, что они обратно соединятся в форму работающего автомобиля очень малы. С гораздо большей вероятностью мы получим ржавчину. Если продолжать смешивать атомы, то рано или поздно получится нормальная машина, но прежде получится очень большое количество ржавых куч. Из этого следует, что гораздо больше способов, которыми можно собрать атомы, получить ржавые кучи. Полностью рабочий автомобиль получится в исчезающе малом числе вариантов. Энтропия автомобиля и ржавой кучи как-то связаны с числом вариантов, которыми можно их получить. Чтобы получить кучу ржавчины, существует намного больше число вариантов, чем тех, что позволят получить автомобиль.

Возьмем другой пример. Обезьяна, стучащая по клавишам пишущей машинки. Почти всегда будет получаться случайный набор символов и очень редко ей удастся построить осмысленный текст. Причина в том, что существует гораздо больше бессмысленных последовательностей букв, чем тех, что имеют смысл.

Любой алфавит имеет определенное количество символов. Но есть более простая система письменности – азбука Морзе. В ней три символа – точка, тире и пробел. Но всегда можно заменить пробел специальной последовательностью точек и тире. Если имеется 110 точек и/или тире, то можно составить 2 110 различных сообщений азбукой Морзе.

Любые символы, с помощью которых можно кодировать информацию называются битами. Бит – это отдельная минимальная единица информации, подобно точкам или тире в азбуке Морзе.

Зачем эти трудности с переводом информации в точки и тире, нули и единицы? Проще же будет использовать буквы алфавита, и они занимали бы гораздо меньше места. Однако суть в том, что каждая буква или цифра несет сразу много информации за счет весьма тонкой разницы между А и Б или 5 и 8. Поэтому в телеграфах и компьютерах используют двоичный код из точек и тире или нулей и единиц.

Из 2 110 возможностей лишь очень малая доля представляет собой осмысленные фразы. Бессмысленные цепочки символов имеют большую энтропию, чем комбинации, составляющие осмысленные фразы. Поэтому если взять осмысленное 110-битное сообщение и начать перемешивать символы, то энтропия будет возрастать.

Второе начало термодинамики, которое говорит, что энтропия возрастает, это просто утверждение – с течением времени мы теряем контроль над деталями. Представим, что капля черных чернил упала в ванну с теплой водой. Вначале можно предположить, что точно известно, где находятся чернила. Но по мере того как происходит диффузия чернил в воде, все меньше и меньше остается информации о местоположении отдельных молекул чернил. Энтропия возрастает. Все стремится к однородности.

Энтропия – это мера того, сколь много информации скрыто в деталях, которые по той или иной причине трудно наблюдать. Из этого следует, что энтропия – это скрытая информация. В большинстве случаев информация скрыта, потому что она касается слишком малых вещей, и слишком многочисленных. Например, вода в ванне. Она содержит информацию о положение и движение каждой из многочисленных молекул воды.

Однако, что случится с энтропией, если охладить воду до абсолютного нуля? В этом случае молекулы сами соберутся в уникальную структуру – решетку, которая образует идеальный кристалл льда. И хотя молекулы слишком малы, чтобы их видеть, зная свойства кристаллов, можно предсказать положение каждой молекулы. Идеальный кристалл вообще не имеет энтропии.

Сколько битов можно хранить в библиотеке?

Давайте поразмыслим над тем, где же находится информация, когда идет речь о каком-либо объекте или событие. Например, вам сообщили, что планета Марс является частью Солнечной системы. Любой человек скорее всего, не усомнится, что он получил порцию информации. Но где же она находится? В чей-то голове? Она слишком абстрактна, чтобы иметь местоположение? Она рассредоточена по всей Вселенной для использования везде и всеми?

Одним из четких ответов можно считать: информация находится на странице книги в виде физических букв, которые, в свою очередь, состоят из молекул. А вдруг в ней находится ложная информация о местоположение. На самом же деле ни одна книга не содержит этой информации. Информация о том, что Марс – это планета Солнечной системы, находится в самой Солнечной системе.

Рассмотрим великую Александрийскую библиотеку. Сколько же она может содержать информации? Предположим, что каждый кубометр был заполнен книгами вроде той, о которой шла речь выше. Размеры самой библиотеки 60x30x12 метров, или около 22 тысяч кубических метров, или 22 миллиарда кубических сантиметров. При плотности 7400 битов на кубический сантиметр получается 1.6×10 14 битов. Количество впечатляет.

Но зачем привязываться к книгам? Можно оцифровать все книги, что позволит хранить намного больше информации. Есть ли фундаментальный физический предел объема пространства, необходимого для хранения одного бита? Можно ли бесконечно делить пространство, наполняя его бесконечным количеством информации? Или существует предел?

Наименьший бит

Джин Уилер считал, что все материальные предметы состоят из битов информации. Он представлял, что бит, будучи самым фундаментальным объектом, имеет самый маленький возможный размер, равный фундаментальному квантовому размеру, открытому Максом Планком. Выходит, что пространство можно разделить на крошечные ячейки планковского размера. Каждая ячейка либо содержит частицу, либо нет.

Вернемся к вопросу о том, сколько информации могло поместиться внутри Александрийской библиотеки. Для этого разделим ее объем – 22 миллиарда см 3 – на ячейки планковского размера. Выйдет примерно 10 109 битов.

Это очень много. Чтобы представить себе насколько большой этот объем информации, вообразим, сколько обычных книг понадобилось бы для такого объема информации. Ответ – больше, чем может поместиться во всей наблюдаемой Вселенной.

После всех примеров логически можно предположить, что максимальное число информации в области пространства равняется ее объему. Однако из самых неожиданных и странных открытий современной физики состоит в том, что максимальное количество информации, которое может содержаться в области пространства, равно площади этой области, а не ее объему.

Энтропия и тепло

Тепло – это энергия случайного хаотического движения. Энтропия – это количество скрытой микроскопической информации. Рассмотрим ванну с водой, которая охлаждена до абсолютного нуля, то есть молекулы зафиксированы в строго определенных местах ледяного кристалла. В таком состояние никакой скрытой информации нет. Энергия, температура и энтропия – все равны нулю.

Теперь добавим немного тепла. Молекулы начинают подрагивать. Следовательно, мы теряем немного информации и число конфигураций, которые можно спутать между собой, возрастает. Так порция тепла повышает энтропию. Если добавлять и дальше энергию для нагревания воды, то кристалл начинает плавиться и уследить за всем становится невозможно. Другими словами, с ростом энергии растет и энтропия.

Энергия и энтропия – не одно и то же. Энергия принимает множество форм, но одна из них, тепло, тесно срослась с энтропией.

Еще немного о втором начале термодинамики

Еще раз вспомним первое начало термодинамики – это закон сохранения энергии: невозможно создать или уничтожить ее; все, что можно – изменить ее форму. Второе начало еще больше приводит в замешательство: неведение всегда возрастает.

Представим прыжок ныряльщика с трамплина в бассейн. Он быстро останавливается, а исходная потенциальная энергия превращается в небольшое увеличение тепловой энергии воды. Следовательно, небольшой нагрев немного увеличивает энтропию. Однако ничто в законе сохранения энергии не препятствует обращению его прыжка. При этом энтропия бы уменьшилась.

К сожалению, такое можно предположить, если учесть лишь первую половину термодинамики. Во второй говорится, что энтропия всегда возрастает. При преобразованиях между различными формами энергии всегда выигрывает тепло. Его становится больше, а других организованных форм энергии – меньше. Общее количество энтропии в мире всегда возрастает.

По этой причине, например, тепло моря невозможно направить на решение мировых энергетических проблем. В целом организованная энергия деградирует, превращаясь в тепло, и обратного пути не существует.

Исходя из названия книги, можно понять, что тепло, энтропия, информация имеют отношение к черным дырам и основаниям физики. Поэтому если понравилась статья и в целом заинтересовал материал, то рекомендую прочесть книгу.